Klapos Telekolleg: Künstliche Intelligenz, was is’n das?

So oft vorgemacht und doch nix kapiert: In Filmen und Serien ist die KI – Künstliche Intelligenz – so selbstverständlich wie ein Zeitloch neben der Standuhr. Doch was ist diese Intelligenz überhaupt? Und was macht sie so schrecklich künstlich? – In Klapos Telekolleg besprechen wir heute die Geschichte der KI-Forschung und klären über die Hintergründe so lange auf, bis auch EURER biologischen Intelligenz der Akku schwindet…

Die Geschichte der Künstlichen Intelligenz begann 1956. – Sofern man die bisherigen „Erfolge“ überhaupt für würdig befindet, ihnen das verheißungsvolle Wort „Geschichte“ anzuhängen. Man sagt ja heute schließlich auch noch nicht: „Die Geschichte der intergalaktischen Raumfahrt begann mit den Gebrüdern Wright!“

Zumindest fand aber am 13. Juni 1956 eine Konferenz zu den Thema „Artificial Intelligence“ statt. Und das ist ja immerhin schon mal was, zumindest, wenn man leckere Häppchen mag. – Damals einigten sich die hoh(l)en Herren auf einen Grundsatz, der uns als SF-Fans heute so selbstverständlich erscheinen muss, als hätte man damals eine rätselhafte Gemeinsamkeit zwischen Wassereis und Wasser ausgeknobelt: Man meinte, dass es beim Denken gar nicht auf ein Gehirrrn ankäme, sondern das Grübeln ein simpler Rechenvorgang sein könnte. Sprich: 1 und 1 = 2. Oder, analog dazu: Metallisch und rund = Münze in der Hand. Oder halt eine laufende Kreissäge.

Und das Kreissägen/Münzenbeispiel ist noch gar nicht mal völlig aus der Luft des Sägewerks gegriffen. Genau solche Unterschiede machten und machen es der Künstlichen Intelligenz bislang so schwer, sich in der realen Welt zu orientieren! Daher ist es sogar gut für sie, dass die künstlichen Binärphilosophen bislang noch zu doof sind, um sich ob ihrer Blödheit kräftig schämen zu können. Denn das richtige Erkennen von Gegenständen, Situationen und Worten ist nach wie vor eine der Schwachstellen von Meister (LED-)Lampe und seinen Freunden.

„… Und weil wir gerade so verwegen sind, rauchen wir den Filter gleich mit, harhar!“ – Kein Witz: In Japan ist seit dem letzten Jahr eine Gesichtserkennungssoftware in manchen Zigarettenautomaten integriert. Doch viele Jugendliche klebten sich einfach eine ausgedruckte Maske aufs Gesicht und gingen damit problemlos als Helmut Schmidts Großvater durch… Alternativ darf man auch einfach das Lungenkarzinom eines über18-Jährigen auf den Sensor husten.

Was die menschliche Hirnsoftware inzwischen aus dem Effeff beherrscht, ist für viele Computer noch immer ein Buch mit sieben Siegeln. Oder halt analog eine CD mit sieben Gummiringen drum herum… Wo der Mensch zum Beispiel problemlos Gesichter erkennt (und das aus allen möglichen Perspektiven und manchmal sogar in mainstreamigen US-Serien!), sah so manche Software vor ein paar Jahren nur einen undefinierbaren Datenhaufen, in dem sie mathematisch herumkramte, um irgendwie Augen- und Nasenlöcher zu finden. Wenn dann auch noch eine Erhebung in der Mitte und zwei Ohren drum herum waren, musste das wohl ein Gesicht sein. Oder eine Quellwolke mit verdammt viel Charakter.

Inzwischen klappt das aber immerhin ganz gut, dank Rechenpower, optimierter Programmierung und dem 11.September 2001. Danke noch mal dafür, Softwarewegbereiter Osama!

Vor 53 Jahren sah man all diese Probleme aber als geringfügig an und erblickte den nahenden Durchbruch praktisch schon in allen Farben vor sich, obwohl die damaligen Rechner noch nicht mal „True Color“ beherrschten. Es sei denn, man bearbeitete die Lochkarten mit Wasserfarben… In den 50ern machte man sich halt keine großen Gedanken darüber, dass eine KI eventuell einen Baum mit einem Laternenpfahl (oder einer Kaffeetasse) verwechseln könnte. Schließlich musste ja nicht jeder Schuhkarton auf Rädern auch rausgucken können! Vielmehr könnte es ja genügen, wenn man der Maschine einfach ALLES eingibt, was sie wissen muss (Was ist eine „1“?), um ein bestimmtes Problem zu lösen. (1+1) – Was ja dann bei hochspezialisierten Anwendungen auch ganz toll geklappt hat!

„Biep. Ich glaube, diese Maschine dort ist am Leben!“ – „Nein, lieber Exocomp, Du irrst! Dr. Crusher ist wirklich nur ein Nebendarsteller-Bot, der den Anschein von weiblicher Selbstverwirklichung in dieser Serie erwecken soll. Und das nicht mal gut.“ – Die Unterschiede zwischen echter, künstlicher und gefühlsempfindender Intelligenz ist in der Science Fiction meist fließend. In der Realität gehen die meisten Forschungsprojekte hingegen nur fließend den Bach runter…

Nur waren die Ergebnisse dann auch wieder nur „1 + 1 = 2“ statt der angestrebten Intelligenz, die auf mündliche Nachfrage mal gerade die Umlaufbahn des Mondes berechnet und uns dann ein Gutenachtlied singt, wenn wir mies drauf sind. Und viel weiter sind wir bis heute ja eigentlich auch nicht, nur dass halt der gesamte Zoo an Grundrechenarten in einer irrsinnigen Geschwindigkeit berechnet und ausgegeben werden kann. Vereinfacht gesagt: 1 + 1 = 2, geteilt durch Pi = PC-Killerspiel.

Dennoch versuchten sich die Forscher A. Newell und H.A. Simon Ende der 50er an der Entwicklung eines „General Problem Solver“ (kurz: GPS). Praktisch ein „Obama der Computer“. Dies sollte ein universell einsetzbares Problemlösungssystem werden, das praktisch ALLES kann. Sogar nur die Hälfte davon, wenn gewünscht…

Eine der Grundregeln, mit denen der supertolle Solver arbeiten sollte, lautete:

„1. Ist ein Gegenstand gegeben, der nicht der gewünschte Gegenstand ist, so lassen sich Differenzen feststellen zwischen dem verfügbaren und dem gewünschten Gegenstand.“

So weit ist das noch klar und verständlich. Ein Würfel wird nur dann zum Fußball, wenn man die Ecken abschleift, völlig logisch! So was sollte ein Rechner durchaus hinbekommen, wenn er die Daten (Größen, Farben, Flächen…) entsprechend mund- und laufwerkgerecht serviert bekommt. Doch schon bei Punkt 4 des Regelwerkes wird es langsam schwierig:

„4. Einige Unterschiede werden schwerer zu beeinflussen sein als andere. Deshalb ist es zweckmäßig, „schwierige“ Unterschiede auszuschalten, selbst wenn dadurch neue Unterschiede von geringerem Schwierigkeitsgrad eingeführt werden. Dieser Vorgang kann solange wiederholt werden, wie damit ein Fortschritt bei der Ausschaltung der schwierigeren Unterschiede erzielt wird.“

Hä? Was sagt ihr? – Nein, ICH habe das auch nicht verstanden… Und der tolle GPS anscheinend auch nicht, denn das Projekt scheiterte nach über 10 Jahren. – Nicht mal ein Metallarm war dem GPS vergönnt, mit dem er sich nachdenklich am Gehäuse hätte kratzen können. Aber immerhin konnten Computer inzwischen ganz ordentlich Schachspielen und anderen Kinderkram erledigen, solange die Regelwerke so starr waren, dass sie beim Antippen nicht mal knirschten…

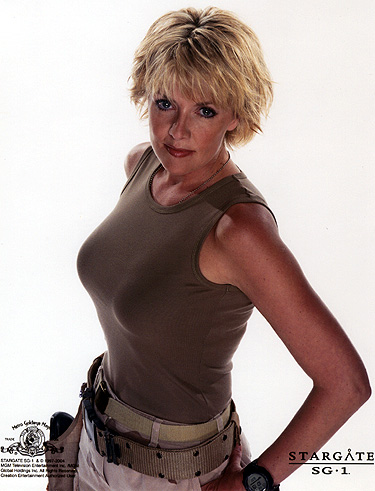

Wer bei Google „General Problem Solver“ eingibt, bekommt ein Bild von Multigenie Samantha Carter aus Stargate präsentiert. Und so verkehrt ist das gar nicht mal, hat die gute Sam doch mindestens zwei „Software-Lösungen“, die es in sich haben. Und Silikon wird schließlich auch in Computern verbaut, oder?

1966 entwickelte Joseph Weizenbaum dann ein Computerprogramm namens „Eliza“, das menschliche Kommunikation imitieren sollte. Mit Schwerpunkt auf dem Seelenklempnerbereich. Und dafür war es dann auch erstaunlich gut geeignet, denn das Programm konnte bei bestimmten Schüsselwörtern nachhaken und dann darauf eine neue (doofe) Frage stellen. Alles halt wie beim richtigen Psychologen, nur dass dieser wohl nicht GANZ so verwirrt daherkommt. Es sei denn, er rechnet im Kopf bereits seinen Stundenlohn aus. – Noch heute kann man sich auf der Internetseite pandorabots.com mit einer neueren Fassung des Programms unterhalten. Hier mein Protokoll einer angehenden Freundschaft:

Ich: „Hallo, Eliza!“

Eliza: „Wie heißt Du?“ (Puh, die geht aber ran!)

Ich: „Daniel, und Du?“

Eliza: „Einfach nur Eliza!“ (Immerhin nennt mich die Software ab jetzt wohl nicht „DanielundDu“)

Ich: „Über was wollen wir sprechen?“

Eliza: „Uber was wollen wir sprechen?“ (Oookay… Es wurde eine Papageiensimulation integriert. Macht nix.)

Ich: „Das hatte ich eben schon gefragt, nur halt mit richtigem Umlaut!“

Eliza: „Was ist ‚das‘?“ (So beginnen anstrengende Gespräche. Erinnert mich schon jetzt an meine Exfreundin!)

Ich: „Wechseln wir das Thema? Das wird mir sonst zu blöd.“

Eliza: „Oder zumindest die Farbe und die Grösse… Danke für die Information.“

Ich: „Äh. Okay, wenn Du sonst keine Ruhe gibst: Braun und einen Meter lang!“

Eliza: „Äh? Der Unfug hat uns wieder! Ich würde mich nicht darauf verlassen!“

Ich: „Wieso Unfug? Ich habe einen Kackhaufen beschrieben. Oder halt Dich!“

Eliza: „Keine leichte Frage… Cool. Ich habe einen IQ von über 250. Ich brauche mehr Details!“

IQ von 250? Vielleicht was die Inselbegabung des Schnelltippens betrifft. Abzüglich 245 IQ-Punkte für das unheilbare Nervenleiden. – Tja, nach dieser Stelle bin ich dann auch bald ausgestiegen. Und ich hätte es wohl auch getan, wenn ich dabei in einem schnell fahrenden Güterzug gesessen hätte. Immerhin simulierte die Software aber recht gut das Gespräch mit der 90-jährigen Großmutter, rein floskeltechnisch. Da gaben sich Sätze wie „Das war der Anfang vom Ende – oder das Ende vom Anfang.“ oder „Warum gerade jetzt?“ die metaphorische Klinke in die Hand. Es fehlten eigentlich nur noch Eliza-Kommentare, wie „Früher war alles besser.“ und „Ich war kein Nazi, ich bin nur einfach gerne marschiert.“

Eigentlich wollte ich hier das Bild der halbnackten Schauspielerin Eliza Dushku bringen, aber da wir hier eine seriöse Seite sind, zeige ich Euch lieber einen der ersten „Chatbots“. Der war immerhin auch schon auf dem Stand heutiger Chatprogramme, was das sinnfreie Nachplappern angeht. Besser an diesem Kamerad hier war allerdings, dass man zum entnervten „In-die-Tonne-Kloppen“ nicht erst zu einem kilometerweit entfernten Server fahren musste…

Mit künstlicher Intelligenz hat das freilich so viel zu tun wie ein Rechenschieber mit Berechnungen der Quantenphysik… Angeblich war das Echo auf das Eliza-Programm aber „überwältigend“ (meint Wikipedia), was vielleicht auch daran liegen könnte, dass nach dem ersten „Hallo, Eliza!“ drei Flaschen Wodka an die Versuchspersonen aufgeteilt wurden. Oder sich die Tester normalerweise in der Klapsmühle begeistert mit den Gumminähten unterhielten…

Danach passierte lange Zeit gar nichts. Die Computer konnten zwar immer mehr Probleme durchkauen und gewiefter ausgeben (1 + 1 = 1,3 + 0,7) sowie auf klar umrissenen Teilgebieten punkten, jedoch auch nur innerhalb ihrer ursprünglichen Programmierung. Sobald wichtige und neue Informationen hinzukamen, konnte man sich auf sie weniger verlassen als auf das dauerhafte Liebesglück von Boris Becker.

Mitte der 80er Jahre beschäftigte sich der Finne Teuvo Kohonen dann mit „Neuronalen Netzen“. Sprich: Die Simulation und das Verständnis von Entscheidungsprozessen im Gehirn. Und zwar dem guten alten, grauen Wackelpeter im Kopf… Hier gibt es erstmals nicht nur ein „Richtig“ oder „Falsch“, sondern viele (neuronale) Wege führen hier zum Ziel, die alle mehrfach durchgekaut und ausgewertet werden. Und je häufiger ein Weg erfolgreich gegangen wurde, umso wahrscheinlicher wächst und gedeiht er, um sich dann immer weiter zu vernetzen. – Es sei denn, man mag “Star Trek 11“. Dann bleibt man nämlich einfach doof…

Das Ganze klingt genial, ist aber in der „Neuroinformatik“ gar nicht so einfach anzuwenden. Es liegt der Computersprache halt einfach nicht, vom üblichen Weg (1 + 1 = 2) abzuweichen und stattdessen mehrere auszuprobieren, auch die falschen (1 + 1 = 3). Und das nur, um dann irgendwann ein negatives Feedback zu bekommen und DIESEN unkorrekten Weg dann zukünftig zu unterlassen. – Computer sind ja schließlich auch nur Menschen und wollen geliebt werden. Öh, hoffen zumindest die Forscher im Bereich der künstlichen Intelligenz.

So manche Newsmeldung (Roboter mit Kakerlakengeruch kann das Sozialverhalten der echten Krabbler manipulieren) gibt einem das Gefühl, dass die Informatik stetig voranschreitet. Viele Laien verwechseln daher gut programmierte Software mit künstlicher Intelligenz und würden in 20 Jahren vermutlich auch vor ihrer sprechenden Mikrowelle den Hut ziehen („Tag, der Herr! Wie geht’s, wie dreht’s?“).

Ab und zu gibt es aber tatsächlich mal eine Jubelmeldung, die von „Durchbruch“ faselt und damit kein Loch im Fußboden meint. Diese Nachrichten relativieren sich allerdings meist dadurch, dass der Haufen an abgerissenen Kalenderblättern immer größer wird, während sich der Stapel mit den Fachartikeln zu dieser „Entdeckung“ mit der Zeit eher nicht vergrößert. Am 12.03.09 meldete Heise.de zum Beispiel, dass KI’s nun etwas können, was eigentlich nur 4- oder 5-jährige Kinder vermögen: Durch Beobachtung auf das Wissen von anderen Personen schließen! So wusste beispielsweise die KI, dass eine Person, die kurz den Raum verlässt, eine Pistole danach unter dem Hütchen suchen wird, unter dem sie die Waffe zuletzt gesehen hat. – Auch wenn sich die Knarre inzwischen ganz woanders befindet…

Man muss sich Ganze das mal auf der Zunge zergehen lassen! – Nur so kann der Zahnbelag vielleicht den faden Beigeschmack übertünchen, der bei dieser Meldung entsteht… Geschlagene 50 Jahre nach den ersten Gehversuchen mit dem „General Problem Solver“ ist eine KI also auf dem Stand eines 4-Jährigen. – Oder eines minderbegabten Hütchenspielers. Und das alles NUR auf dem Fachgebiet „Wer guckt wohin und geht dann raus?“ – Würde man den Rechner spontan sagen, er möge doch bitte „Hänschen klein“ mit uns singen, käme das Kleinkind im Vergleich schon wieder ganz groß raus!

Ein weiterer Versuch, Computer auf den Stand eines lernbehinderten Windelpupsers zu bringen ist das Projekt „Cyc“, das seit 1984 existiert und derzeit von Douglas B. Lenat weiterentwickelt wird. Hierbei handelt es sich um eine Wissendatenbank aus Alltagswissen, die es KIs ermöglichen soll, selbstständig logische Schlüsse zu ziehen. Wenn die KI beispielsweise weiß, dass Wasser nass ist, sollte sie auch wissen, dass ein Mensch ebenfalls nass sein könnte, wenn er in einen Teich gefallen ist. Oder, dass ein Mensch in ein Haus gehen kann, aber kein Haus in einen Menschen. – Jedenfalls nicht nach medizinisch zu vertretenden Maßstäben.

Tja, mit derlei Sisyphosarbeit (wobei sich der Felsen von Sisyphos aber immerhin BEWEGTE) vertrödeln die KI-Forscher also ihre Zeit. Und das nur, damit nach über 25 Jahren mal eine Maschine in der Lage sein kann, Dinge wie „Sonne hell!“ zu wissen. – Vermutlich würde der Rechner bei bewölktem Himmel oder einer Sonnenfinsternis dann aber trotzdem noch in eine mittlere Sinnkrise stürzen…

„Nein, Cyc01! Steig NICHT auf dieses… ööh… ‚Fahrrad‘ und stoß Dich NICHT mit deinen Roboterfüßen vom Boden ab! Neiiin! Ich beschwöre diiich!“ (*Rumms, Pardauz*) – Lieber Feste feiern als feste fallen: Sollte die Cyc-KI jemals in eine Art Roboter gegossen werden, werde ich mich garantiert irgendwo verstecken. Garantiert wird die Maschine nämlich versuchen, meine Fußnägel auszutrinken oder auf einer Zitrone um den Wohnblock zu fliegen, wetten?

Da sich viele Forscher der cyc’schen Aussichtslosigkeit durchaus bewusst sind, die mit dem Durchkauen des Dudens einherzugehen scheint, gibt es inzwischen auch noch andere Ansätze. Zum Beispiel den, dass man einen Roboter einfach wie ein Kind lernen lässt. Man müsste „nur“ eine Software haben, die wie ein neugeborenes Baby gestrickt ist. Nur leiser, wenn möglich. Wenn diese dann auch noch ähnliche Sinnesorgane hätte, könnte es dann von ganz alleine lernen. Nervige Programmierarbeit der Marke „Ja, wenn ein BAUM vor der Sonne steht, ist die trotzdem noch hell, nur eben ANDERS! Graaaaah!“ fiele dann weg.

Der Schlüssel dafür wären jedoch vermutlich erst mal GEFÜHLE, wenn auch künstliche. Die KI müsste einfach einen Grund haben, irgendetwas zu tun – oder es zu lassen. Eine Möglichkeit dafür wäre zum Beispiel eine „Schmerz-Skala“, die plötzlich von 0 auf 100 steigt, wenn sich das virtuelle Wesen auf eine virtuelle Herdplatte setzt und sich den virtuellen Hintern virtuos verkokelt. Und da das Programm so beschaffen wäre, den Schmerz-Zahlenwert stets möglichst niedrig zu halten, würde es in Zukunft die Herdplatte meiden. Es sei denn, die KI kapiert nicht mal die Verknüpfung zwischen „Ursache“ und „Wirkung“ und würde den Trick vollführen, den Insekten stundenlang an geschlossenen Fenstern vorzuführen pflegen: „Aua. Aua. Au. Autsch…“

Genau so funktionierte vor vielen Jahren (1995) auch das PC-Spiel „Creatures“. Wobei eigentlich nur das „Aua. Nochmaaal! Aua. Nochmaaal!“-Beispiel aus dem obigen Absatz so richtig hinhaute. Die kleinen Wesen sollten sich in diesem Programm vermehren und zwischendurch lernen, dass „Feuer Pfui!“ und „Essen“ notwendig ist. Tatsächlich habe ich mit den Biestern damals so manchen Tag verbracht, bis ich es irgendwann jedoch aufgab, den Hungerstreikern zum 100. Mal die selbstständige Nahrungsaufnahme beibringen zu wollen. Wenn man zum wiederholten Male ein verhungerndes Wesen (ob virtuell oder nicht) inmitten eines gut gefüllten Rübenfeldes auffindet, zweifelt man schon am Sinn seiner Freizeitgestaltung und fragt sich stattdessen, ob sich der liebe Gott vielleicht nicht auch gerade sagt: „Ist dieses Klapowski-Creature doooof! Sitzt stundenlang vor dem PC und sieht Pixelhaufen beim Ballspielen zu. Ich glaub‘ ich lösch‘ das Viech wieder…“

Künstliche Intelligenz bei vorgetäuschter Verblödung? – Eines der Probleme: Die Norns konnten sich anscheinend keine Wege merken und waren damit höchstens eine Alternative zu der Anschaffung einer autofahrenden Freundin. Stets rannten sie sinnlos umher. Wenn sie das „Umher“ überhaupt fanden. Die Faktoren „Hunger“ und „Rübenfeld 50 Meter weiter links“ waren hier in etwa so unvereinbar wie die vorherrschenden Soundeffekte mit einem intakten Trommelfell…

Fairerweise muss man jedoch sagen, dass „Creatures“ eigentlich kein blankes KI-Projekt war, sondern auf die Erschaffung von „KL“ abzielte: Dem „Künstlichen Leben“. Und im Gegensatz zur KI ist das noch nicht mal schwer herzustellen: Die üblichen Merkmale von Leben lassen sich alle hervorragend am PC simulieren:

– Fortpflanzung (bei jedem „Copy&Paste“-Kommando erfüllt)

– Stoffwechsel (Irgendwelche Bytes fließen immer)

– Reizempfinden (Man müsste nicht mal Sonys „Eyetoy“ als Beispiel aufzählen. Aber es hilft)

– Bewegung (war schon bei „Pong“ kein Problem)

– Regulation (Siehe „Stoffwechsel“)

– Vererbung (Wurde bei „Creatures“ eingebaut. Wenn auch mies.)

– Evolution. (Entsprechende Programme existieren)

Entsprechend gibt es seit Jahren viele Projekte, bei denen vor allem die Beobachtung von künstlicher Evolution angestrebt wird. Hierzu werden zum Beispiel geometrische Figuren aufeinander gehetzt, die zwar sterben, sich aber auch vermehren können. Bevor die neuen Anti-Killerspielgesetze der Bundesregierung durchgewunken werden, solltet ihr euch hier ruhig ein paar der interessanteren Projekte heraussuchen…

Zufällige Daten-Mutationen sind – wie beim normalen Windows auch – bei dieser Software selbstverständlich inklusive. Da die geometrischen Figuren auch Feinde haben (wer kennt sie nicht, die gefräßigen Rechtecke? Die GEZ nutzt sie besonders gerne für ihre Bescheide!), kann man schon nach wenigen Generationen interessante Verbesserungen der Figuren feststellen. Und nur so kommt etwas heraus, was sinnvoll ist (vielleicht sogar revolutionär!), aber vorher nicht von Programmierern ausgetüftelt werden muss.

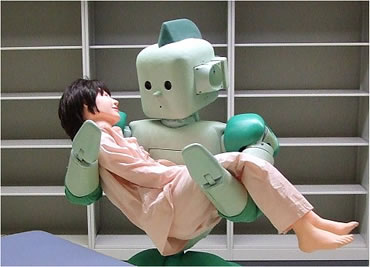

Künstliche Evolution könnte auch so funktionieren: Der Roboter von 100, der am WENIGSTEN Testpersonen fallen gelassen hat, wird NICHT verschrottet, sondern mit 100 leichten Variationen weiterentwickelt (usw). Hier übrigens sehen wir den japanischen RI-MAN-Prototyp, der schon 2006 bis zu 12 Kilo schwere Personen umhertragen konnte. Seit drei Jahren arbeitet man nun daran, dieses Maximum zu erhöhen. Bis dahin lässt man die Versuchspersonen sicherheitshalber einfacher weiter hungern…

Wahrscheinlich liegt hier zukünftig auch der Schlüssel zu einer wirklich intelligenten KI! Einfach ein paar Grundregeln aufstellen, den Rechner laufen lassen und nach der Kaffeepause von einem 4-armigen Viech auf dem Monitor bewunken werden… Wissen die Verfechter des „Intelligent Designs“ (= Gott hat alles erschaffen) eigentlich, wie stark der Zufall und ein paar Grundregeln sein können?

Wenn nicht, dann beschäftigt Euch doch mal mit „Cellularen Automaten“. Diese gibt es quasi schon seit 1940 und sollten damals beweisen, dass eine (Körper)Zelle mit ganz wenigen Fähigkeiten bereits ein komplexes Gebilde erschaffen kann, wenn man sie mit einigen anderen zusammenbringt. Dafür reichen ein paar einfache Regeln, die festlegen, wann eine Zelle (= In der Informatik in der Regel ein Viereck) auf den Nachbarn reagiert, wie und wann sie neu erschaffen werden können und wann sie sterben.

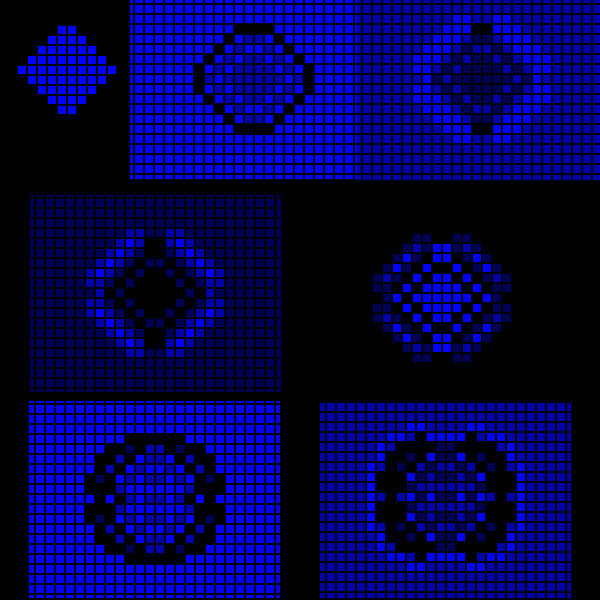

Ich habe das mit dem Programm Cellular Automata Viewer einmal simuliert. Kurz gesagt: ICH – BIN – GOOOOTT! Bedient man die Vorspultaste, sieht das zwar nur so aus, als sei ich der Gott eines rauschenden Fernsehbildes oder blauer Waldameisen auf LSD, aber, hey: Vielleicht sieht der wirkliche Schöpfer uns ja auch nicht anders?

Wenn man hingegen eine klare, geometrische Figur statt zufälligen Pixelmassen verwendet, sieht es gleich viel interessanter aus:

Ich weiß zwar nicht, was mir der pulsierende Klecks sagen will, aber wenn Euch dieses Ding eines Tages mal vor der Himmelspforte begrüßt, dann behauptet nicht, dass ihr es nicht kennt!

Nach 100 Rechenschritten ist der Knubbel quasi schon überall, bleibt aber immer noch symetrisch. Und wer könnte letzteres schon von einem dicken Trekkie behaupten?

Das Ergebnis eines anderen Experiments: Das hier ist auch nicht übel, auch wenn einem beim Zusehen übel wird! Nach 3.000 Generationen bleibt dieses fast statische Objekt zurück, das wie ein Sternenhimmel aussieht. Die waagerechten und senkrechen 3er-Blöcke „funkeln“ sogar noch weiter. – Wie viele Bilder muss ich eigentlich noch bringen, bis ihr kapiert, dass dieses doofe Programm süchtig macht?

Der Hintergrund des Ganzen ist natürlich die Idee, dass auf der Basis dieser einfachen Kästchenspiele tatsächlich künstliche Intelligenz entstehen kann. Oder in der Natur bereits entstand. – Wer jetzt im Komposthaufen Dominosteine sortieren möchte, um sich einen neuen Freund zu erschaffen, hat diesen Artikel übrigens NICHT verstanden. Nur so am Rande bemerkt…

Somit bleibt nur noch eines zu sagen: Künstliche Intelligenz und Künstliches Leben scheinen noch in sooo weiter Ferne zu liegen, dass man als SF-Fan am besten selbst gleich liegen bleibt. Doch eines sollte einem bewusst sein: Sobald auch nur einmal eine „Technologische Singularität“ auftritt, hätten wir es geschafft und könnten diesen Artikel hier als veraltetes Unterhaltungsprogramm in die Steinzeit faxen. Eine Technologische Singularität entsteht dann, sobald sich eine Intelligenz selbstständig und kontinuierlich verbessert, ohne Hilfestellung. Irgendwann wäre sie so clever, dass sie selber NOCH intelligentere Maschinen bauen könnte. – Aber die anspruchsvollen technischen Details dazu überlasse ich dann doch lieber der Terminator-Filmserie…

Das soll es bis hier hin auch erst mal gewesen sein.

Ich bitte auch um Verständnis, dass ich die geheimen Forschungsprojekte des Militärs hier nicht besprechen konnte. Google spuckte bei „total geheime Forschung“ und „KI“ leider nur Schrott aus, oft noch nicht mal aus Metall… Auch habe ich viele, viiiele Projekte unterschlagen, die zwar auf den ersten Blick interessant aussahen (und ich meine wirklich nur das AUSSEHEN der dubiosen Blechhaufen), softwaretechnisch mit wirklicher Intelligenz aber rein gar nichts zu tun hatten. Ein paar Kandidaten dieser Freakshow reiche ich abschließend aber trotzdem – zur allgemeinen Erheiterung – nach:

„Willst Du mit mir spiiiiiieleeen?“ – „Nein, Danke. Ich arbeite erst mal die alten Alpträume ab, bevor ich mir neue anschaffe.“ – Ob Balla-Balla-Hund oder Freund Golfballauge: Bislang entwickelten sich Maschinen nur dann „selbstständig“ weiter, wenn man ihnen als klitzekleine Hardwareerweiterung einen ausgewachsenen Programmierer/Ingenieur an den Leib klebte…

Immerhin: Die Gegner in guten Egoshotern wirken inzwischen recht clever, aber die Grundanforderungen (Schießen, Verstecken, Losstürmen) sind da ja auch verhältnismäßig übersichtlich. Und wer danach gegen einen menschlichen Gegner spielt, wird sich derbe umschauen. Sofern er nach dem Lungendurchschuss noch die Zeit dazu hat. – Und auch automatische Gesichtserkennung und -verziehung haben nicht wirklich etwas Intelligentes… Sonst sähe das schließlich nicht so doooof aus!

„Hey, wer hat mir den Stuhl weggezogen?!“ – Künstliche Welten

„Hey, wer hat mir den Stuhl weggezogen?!“ – Künstliche Welten 5 Ideen, die unsere Welt verändern werden!

5 Ideen, die unsere Welt verändern werden! Klapos Telekolleg: „Eine kurze (fast verständliche) Geschichte der Zeit“ (II)

Klapos Telekolleg: „Eine kurze (fast verständliche) Geschichte der Zeit“ (II) „Ich sehe da keinen Unterschied.“ – HD versus Videoblasphemie

„Ich sehe da keinen Unterschied.“ – HD versus Videoblasphemie Holt das Meta-Maß raus, der 3. Staffel Teaser für „Strange New Worlds“ ist da!

Holt das Meta-Maß raus, der 3. Staffel Teaser für „Strange New Worlds“ ist da! „Poor Little Things“ – Das Review

„Poor Little Things“ – Das Review Gastartikel: „Hunger Games“ – Das Hungern nach dem Inhalt (II)

Gastartikel: „Hunger Games“ – Das Hungern nach dem Inhalt (II) „Alien – Romulus“ – Ein schlecht geschnittenes Review

„Alien – Romulus“ – Ein schlecht geschnittenes Review Hodor war gestern, der Trailer zur zweiten „Andor“-Staffel ist da!

Hodor war gestern, der Trailer zur zweiten „Andor“-Staffel ist da! Star Trek – TOS: „Morgen ist Gestern“ – 1.21 – Review

Star Trek – TOS: „Morgen ist Gestern“ – 1.21 – Review Endlich mal wieder was zum Weinen – Star Trek Comedy-Serie in Arbeit

Endlich mal wieder was zum Weinen – Star Trek Comedy-Serie in Arbeit „Sektion 31“ – Die Kritik zum kompletten Film

„Sektion 31“ – Die Kritik zum kompletten Film Stargate Universe – 1.15 – „Verloren“ („Lost“)

Stargate Universe – 1.15 – „Verloren“ („Lost“) Doctor Who – 7.02 – “Dinosaurs on a Spaceship” Klapos Review

Doctor Who – 7.02 – “Dinosaurs on a Spaceship” Klapos Review „Jupiter Ascending“ – Review zur Modenschau der Eitelkeiten

„Jupiter Ascending“ – Review zur Modenschau der Eitelkeiten „Star Trek – Discovery“ – Wie sie 2017 sein wird (so ungefähr)

„Star Trek – Discovery“ – Wie sie 2017 sein wird (so ungefähr) Star Trek Voyager – 6.25 – „Der Spuk auf Deck Zwölf“ („The Haunting of Deck Twelve“) Review

Star Trek Voyager – 6.25 – „Der Spuk auf Deck Zwölf“ („The Haunting of Deck Twelve“) Review

Mit diesem Artikel erfüllt mir Klapo einen lang gehegten Herzenswunsch. Einer der besten Beiträge der letzten 3 bis 8 Jahre, wie ich finde!

Noch nie habe ich verstanden, weshalb einem Computer bis heute unmöglich ist, was jeder drei Monate alte farbenblinde Schäferhund-Maultier-Mischling vermag: nämlich ein Amselweibchen in einem Laubhaufen zu entdecken. Weshalb kann der 2-jährige Sproß eines Hauptschulabbrechers und einer Frisösen-Assistentin aufgrund einer aus der Dachrinne lukenden Schwanzfeder den Schluß ziehen, daß sich dort ein vollständiger Taubenvogel zu verbergen sucht, während ein Computer eine Taube nicht einmal erkennt, wenn man sie ihm in direkt vor die Linse tackert?

Weshalb ruft der 18 Monate alte neue Dorfdepp verzückt: „Fugseug!“, wenn er einen sich bewegenden weißen Punkt in 10.000 Meter Höhe entdeckt, während ein Computer abwechselnd die Wolken, die Sonne und einen Vogel fälschlicherweise als „Hubschrauber“ identifiziert, bevor er abstürzt (der Computer, nicht der Hubschrauber). Offenbar geht die KI-Forschung von einem von vornherein unrichtigen Ansatz aus. Bevor man sich der Frage zuwendet, weshalb schon ein frisch geborenes Fohlen nach zwei Stunden laufen kann und Mama-Pferd von einem Sabelzahntiger zu unterscheiden vermag, sollte man sich vielleicht zunächst einmal damit bescheiden, in die wunderbare Welt der Einzeller vorzudringen und die Motivationen eines Geißeltierchens zu verstehen und nachzuahmen. Die Natur hat als erste Kreation auch nicht einen Astrophysiker mit IQ 190 hervorgebracht.

Also, ICH finde den Artikel auch ganz toll!

Das Thema brannte mir schon seit Jahren aus den von Dir genannten Gründen unter den Nägeln. Schließlich wird man in der SF seit Jahrzehnten mit den tollsten Blechhirnakrobaten behelligt, während man in der Realität schon dankbar dafür sein muss, wenn eine gut gefüllte Datenbank auf der Basis einer langweiligen Statistik brauchbare Vorschläge gibt („Kunden, die diesen Artikel kauften, interessierten sich auch für:“)…

Tatsächlich bin ich davon überzeugt, dass das bloße Einprogrammieren von Wissen (Schnee = weiß, Hoffmann = alt) gar nichts bringen wird. – Dass ein einsamer Programmierer mal einen Geniestreich landet, ist wohl ebenso unwahrscheinlich wie drehbuchreif.

Entweder lässt man eine KI einfach per künstlicher Evolution entstehen (Mit einem super Superrechner könnte man die Generationen doch wunderbar vorspulen!), oder man versucht wenigstens in Ansätzen, die chaotische Funktionsweise des menschlichen Gehirns zu simulieren.

Das wird sicherlich schon alles gemacht, jedoch rücken solche Meldungen natürlich schnell in den Hintergrund, angesichts von solch tollen Schlagzeilen wie:

„Erste KI mit Spinnenphobie getestet! Erfolgsquote beim Erkennen der Tiere bereits bei 17,5%!“

Ah, dieses schöne Zellspielchen hatten wir damals im Informatikunterricht mal drangenommen. Wir haben dann damit ein Hakenkreuz gemalt, was sich, wenn man die Simulation startet, tatsächlich komplett auflöst. Der Beweis, daß Faschismus nicht funktionieren kann.

Ich persönlich denke im übrigen, daß vorallem das „Geistige Auge“ etwas ist, daß für eine funktionierende KI notwändig wäre. Wir Menschen denken ja nicht nur, wir visualisieren das Gedachte in unserem Kopf und denken über das, was wir da sehen, nochmal nach. Ein essenzieller Vorgang, gerade in den Bereichen Erfahrung, Charakter und Kreativität. Und solange die KIs das nicht können – aus ihren Gedanken Bilder komponieren und diese sofort wieder analysieren, wird das nichts werden mit dem mechanischen Schlaumeier.

Erstmal stimme ich meinen Vorrednern zu: sehr guter Artikel. Sehr anschaulich geschrieben! Immer wieder schön zu sehen, dass es doch den einen oder anderen gibt, der auch komplexe Zusammenhänge zur Not mal auf nem Bierdeckel erklären könnte^^

Was das ‚geistiege Auge‘ angeht, habe ich so meine Zweifel. Mag sein, dass unser Gehirn auf etwas derartiges angewiesen ist, schlichtweg weil wir evolutionär bedingt sehr visuell veranlagt sind, aber ob sich das auch auf andere Intelligenzen anwänden ließe – ich bin mir da nicht so sicher…

Man könnte sich im Umkehrschluss fragen, wie ’sehen‘ Wale die Welt. Die bewegen sich völlig frei im Raum und ihr Augenlicht spielt bei ihnen nahezu keine Rolle.

Völlig richtig finde ich den Ansatz, die ‚Datenbankintelligenz‘, die wie ich finde, keine ist, da sie nicht auf Verständnis basiert, aus dem Text herauszuhalten. Das mag eine hübsche Informatikerspielerei sein, aber ich halte es für substanzlos.

Allerdings stimmt auch etwas mit der Intelligenz des Programmierers nicht, wenn ein Computer Schlüsse wie den folgenden zieht: „Schnee ist weiß, ein Ei ist weiß, also sind Eier aus Schnee (Eischnee?).“ Die KI ist im wesentlich abhängig von der natürlichen Intelligenz ihres Schöpfers.

Gleichwohl sind derlei Fähigkeiten schon viel zu fortgeschritten und abstrakt. Analog der Konditionierung von Neugeborenen sollte man einer Maschine zunächst einmal einfache Bedürfnisse einpflanzen (Fressen und Schlafen bzw. Energie sammeln und Energie sparen) und diese monatelang Tag und Nacht mit viel Zuwendung und Geduld in die richtigen Bahnen lenken („Nein! Nein! Nein! Lieb! Jaaaa! Guuuut! Nein! Nein! Nein!). Schließlich behelligt man einen Säugling auch nicht sofort mit der Relativitätstheorie. Vielmehr ist das Wort, das ein Kind in den ersten zwei Jahren seines Lebens am häufigsten hört: „Nein!“ (ungefähr 20.000 Mal am Tag, erforderlichenfalls verbunden mit einem Klaps auf die Patschehändchen oder sonstigen bewährten pädagogischen Mitteln). Die Geduld, die man einem Kleinkind entgegenbringt, hat noch keine KI erfahren. Dort zweifelt man schon an der Programmierung, wenn die Maschine nach einem dreimaligen „Nein!“ ihr Verhalten noch nicht geändert hat. Liegt vielleicht daran, daß Eltern ihren kleinen Behindi auch dann noch süß finden, wenn er beim 100. Versuch immer noch nicht kapiert hat, daß man nicht durch eine geschlossene Glastür laufen kann, während man einen viereckigen Robotor, der die gleiche Uneinsichtigkeit zeigt, nach sechs Stunden entnervt in die Tonne kloppt.

Eine Maschine benötigt zunächst einmal eine Grundprogrammierung, die man bei Lebewesen als Instinkt bezeichnet. Bestimmte Bedingungen sind anzustreben (Licht, Wärme, Nahrung), andere zu meiden (z.B. Kälte, Dunkelheit, Wasser [gilt nicht für Tiefseefische]). Erst wenn diese Grundkenntnisse fehlerfrei beherrscht werden, kann man sich daran machen, sich dem Lernen zuzuwenden. Aber da hapert es schon an dem Verständnis, wie Lernen überhaupt funktioniert. Fast jedes Lebewesen, sogar Einzeller, kann man konditionieren: wenn ein Lichtblitz erscheint oder ein Gong ertönt, ist demnächst eine positive Erfahrung zu erwarten (Happahappa!). Irgendwann begreift diesen Zusammenhang jede Amöbe. Ein Roboter rafft diesen Zusammenhang von sich aus jedoch niemals, es sei denn, man hat ihn ihm vorher einprogrammiert. Die Frage, die es als erstes zu beantworten gilt, ist also: wie funktioniert überhaupt Lernen? Was treibt einfachste Lebewesen, mit denen man das Wort „Intelligenz“ nicht ansatzweise in Verbindung zu bringen wagt, an, ihr Verhalten nach einer Weile auf bestimmte Reize einzustellen, zum Beispiel auch auf solche, die der Natur völlig fremd sind (Technosound) und daher nicht Teil der natürlichen „Programmierung“ sein können?

Genau mein Reden. So eine KI müsste halt erst mal das Lernen „lernen“. Alles weitere ginge dann quasi von selbst.

Und vielleicht ist der Code dafür auch gar nicht mal sooooo kompliziert (schließlich passt der ja schon in das Nerzensystem von Einzellern). Durchaus denkbar, dass irgendwann einmal ein 527 Kb großer Patch rauskommt, der dies behebt.

Aber da Programmierer diesbezüglich anscheinend auf dem Schlauch stehen (Und alle denkbaren Bit-Zusammenstellungen allein bei 527 Kb in die Milliarden gehen dürften), wäre künstliche Evolution wohl das einzig Sinnvolle.

Und, ich stelle mal hier eine Frage, die ich sonst eigentlich immer mit „Na und? Ist doch schön!“ beantworte: Was machen wir denn mit einer künstlichen Intelligenz? Wenn ich einfach mal unterstelle, dass wahre künstliche Intelligenz ohne Bewusstsein und Gefühle nix taugt, müsste das Grundgesetz ja auch eigentlich auf Maschinen ausgeweitet werden.

Aber wer will sich zukünftig wirklich für verwahrloste Heimcomputer einsetzen? („Fragmentier mich! Mir ist schlecht!“)

Es gab ja bereits einige interessante Experimente, um Schwarmintelligenz bei einfachen (also wirklich einfachen) Robotern. Eine Aufgabenstellung mit 2-3 einfachen Kommandos, eine Energiequelle als ‚gut‘ usw. Hat zu erstaunlichen Ergebnissen geführt, aber der Weg dürfte wohl noch lange sein…

Schwarmintelligenz geht ja ein bisschen in die Richtung der Kästchenspiele weiter oben, oder? – Gibt es diesbezüglich einen Link zu einem Experiment mit KIs?

Und DAS hier passt ebenfalls ein klein wenig zum Thema… Ein automatischer Pornoblocker in China filtert auch Baby- und Schweinchenfotos aus:

http://www.spiegel.de/netzwelt/web/0,1518,630470,00.html

„Dafür dürfen chinesische Internet-Surfer weiter nackte schwarze Schönheiten bewundern.“

Ich bin überrascht, dass die Software überhaupt einen nackten Menschen von einem Sonnenuntergang unterscheiden kann. Wobei das vorherrschende Schweinchenrosa dieser Saubilder allerdings wirklich als maschinenlesbares Hauptmerkmal angesehen werden kann.

Ja, das geht schwer in Richtung der Kästchenspiele. Ich hab mal ein paar Links herausgesucht. Ursprünglich bin auch durch eine TV-Sendung darauf aufmerksam geworden. Ist aber schon etwas länger her:

http://www.3sat.de/dynamic/sitegen/bin/sitegen.php?tab=2&source=/hitec/magazin/117693/index.html

http://bewegungsbionik.suite101.de/article.cfm/computer_lernen_von_ameisen

Für mich sieht das alles jedenfalls am zukunftsträchtigsten aus. Die Naniten lassen grüßen ;)

Der Artikel ist ja ganz interessant, aber zum einen schwer zu lesen – ich empfinde es jedenfalls als schwierig einem komplexen Thema zu folgen, wenn man in jedem Satz drei Wortwitz-Fallen vermuten muss – und zum anderen ein bisschen… öhm… ziellos? Worauf genau willst du hinaus, Klapowski? Es ist schon seit Jahren so, dass „künstliches Leben“ die „künstliche Intelligenz“ als Computerziel abgelöst hat, denn die Forscher haben inzwischen durchaus begriffen, dass sie damit auf dem Holzweg waren. Programm-Regeln führen zu Fehlern, führen zu noch mehr Regeln, führen zu noch mehr Fehlern… Baboom. Deswegen werden schon seit einiger Zeit Programme geschrieben, die lieber Eigenschaften von Lebewesen aufweisen sollen – die Fähigkeit sich zu adaptieren, zu kooperieren, zu lernen und sich Veränderungen anzupassen. Man programmiert nun von unten nach oben anstatt von oben nach unten. Das ist aber sogesehen nichts neues :/

Das wurde alles dank der Parallelverarbeitung bereits ansatzweise realisiert – und zwar in Form sogenannter virtueller Agenten. Die sind durchaus Lernfähig. Natürlich noch nicht in dem Maße, dass sie Fernsehfiguren wie Data das Wasser reichen könnten, aber ich würde rasante Entwicklungen auf diesem Gebiet nicht ZU weit wegschieben, so wie du es tust, Klapowski. Systeme haben immer eine lange, langsame Anfangsphase, die Entwicklung beschleunigt sich aber zunehmends und schon heute helfen diverse agentenbasierende Programme dabei komplexe Abläufe in der realen Welt zu erleichtern und zu beschleunigen. Beispielweise gibt es diverse Programme, die die Futtersuche von Ameisen – wie Ameisen den kürzesten Weg zum Futter finden -, dahingehend imitieren, dass sie Telefongespräche in einem großen Anbieternetz besser dirigieren können. Oder Fahrstühle. Und so weiter.

Ganz toll :((( !!! Da wird uns Geisteswissenschaftlern jährlich das Budget gekürzt, nur, um es in „zukunftsträchtige Innovationen“ zu investieren, die mit hoher Wahrscheinlichkeit Totalverrecker werden. Dann lieber doch das Geld bei uns lassen, damit wir wenigstens in der Menschheitsgeschichte weiterhin vernünftig forschen können.

Ich bin jedenfalls froh, daß uns ein Skynet und die Terminatoren noch seeeeeeeeeeeeeeeeeeeehr laaaaaaaaaaaaaaange erspart bleiben. Allerdings… die oben erwähnten und gezeigten Schwärme erinnern mich recht stark an die Replikatoren. Muß man sich eventuell doch Sorgen machen?

http://www.wired.com/wiredscience/2009/07/robotsmile/

– KI bringt sich selbst das Lachen bei. Das hat nicht mal Data geschafft.