Zukunftia erklärt: Die KI-Revolution (Teil 2)

In den letzten Tagen gab es so viele KI-Ankündigungen von (z.B.) den Chinesen, dass man mit dem Sammeln der Links und Videos kaum hinterherkommt. Daher habe ich erneut fast alles gelöscht, die publikumswirksameren Uralt-Sachen etwas aufpoliert und hier reinkopiert. Diesmal geht es um die Warnungen des Leopold Aschenbrenner (wohnt der in Höxter/Westfalen? Name klingt erstaunlich wenig nach SF?), dazu um ein paar Videotools und ein unheimliches Gespräch mit einer KI, die sich einen Hemdsärmel wünscht, um ihre AdvoCard polieren zu können.

(Das Eingangsbild oben ist übrigens ChatGPTs bildliche Interpretation dieses kompletten Textes – der übrigens „humorvoll“ sein soll. Na jaaa…)

Als weiterer kleiner Aufwärmer ein Bild, das Chat GPT4-o für mich gezeichnet hat – als „Selbstportrait“ von sich selbst. Ohne Anweisungen.

Wichtig: Streng künstlerisch – oder bei der Frage nach potenziellem „Bewusstsein“ – hat das wenig Aussagekraft, aber irgendwoher kommen ja diese Bilder, die Assoziationen, all die Farben aus dem Delphin-Malkurs alternder VHS-Hausfrauen.

Und somit sagt dieses Bildchen immerhin aus, wie das System trainiert wurde – oder wie die Programmierer möchten, dass diese Technologie wahrgenommen wird. Oder welche Schlagwörter besonders stark gewichtet werden (kreativ, orange, niedlich…). Oder welche vielleicht sogar aussortiert wurden (Apokalypse, unausweichlicher Tod).

Ist das schon Manipulation? Die Farben, der Positivismus? Wäre DAS nicht genau das Bild, das der bärtige Herr im Dystopie-Klassiker „1984“ total gerne abnicken würde? Oder hat man hier einfach zu viele deutsche Bedenkenträger in die Übungsdaten einfließen lassen? („Bilder von MEINEM hässlichen Haus bei Google Street View? Datenkrake, oder watt?!“)

Es ist egal, was wir erwarten

Nach dem letzten Artikelchen gab es eine kurze (aber dafür fruchtlose) Diskussion darüber, wie egal, undurchschaubar oder schattenhaft das mit dem KI-Gedöns eigentlich ist.

Dabei spielt es keine Rolle, was wir Laien uns vorstellen können. Ob wir die nächsten Jahre weiterhin Boomer-haft von Skynet, Commander Data oder dem Film „Her“ schwafeln werden, ohne zu den ECHTEN Gefahren und Möglichkeiten durchzudringen.

Ob wir uns gegenseitig grinsend erzählen, dass KIs irgendeine nebensächliche Aufgabe nicht toll erledigen werden. („30% der Matheaufgaben falsch gelöst. Loooooser!“)

Die Revolution ist trotzdem bereits im Gange. Und nein: Ich habe noch NIE das Wort „Revolution“ im Bereich einer technischen Neuerung benutzt.

Es ist dabei egal, ob man gefährliche Systeme theoretisch abstellen könnte, indem man lustig am Stecker rumdaddelt – niemand stellt schließlich das Internet ab, „nur“ weil es Fake News, Scamming, Shaming und Trolling gibt.

Darum geht es nicht. Denn die Realität wird eh komplexer, unterhaltsamer und auch gefährlicher sein.

Systeme wie ChatGPT (oder viel bessere) werden einfach im Hintergrund Auswertungen vornehmen, von denen wir heute nur träumen können – die Geheimdienste sogar feucht. Abfragen wie „Hat Martin Löwenstein in den letzten 13 Jahren auf WhatsApp jemals über Steuerbetrug gesprochen?“ oder „Fasse den politischen Charakter aller in Word geschriebenen Dokumente zusammen“ könnten bald automatisiert erfolgen.

Ich erinnere erneut daran, dass Microsoft seine nächsten Windows-Version allwissend, all-auswertend und all-erinnernd machen möchte.

„Windows Recall“ sollte mehr aufzeichnen, als wir jemals gedacht haben. Mitsamt minutenlangen(!) Videos, bei denen nicht mal die Maus bewegt(!) wird. Doch vor 24 Stunden ruderte Microsoft sanft zurück – vorerst.

(Staatsschutz-)KIs werden andere (Auswertungs-)KIs mit derlei Anfragen automatisiert beauftragen, während („Ich schicke mal die Geheimpolizei vorbei“-)KIs am Ende entscheiden, wer vor 5 Jahren mal was von „Scholz abschieben“ gesagt hat.

Oder halt die krassere Variante in China, Russland, Nordkorea & Co.

Massenüberwachung ist bald kein Problem mehr. Jeder Kontext in jedem Subkontext kann dann ausgewertet und verknüpft werden. Längst wird über die Gefahr eines „Digitalen Zwillings“ diskutiert – KI-Modelle von unseren Persönlichkeiten, die alles beinhalten, was wir je gesagt, geschrieben oder getan haben (sofern letzteres aufgezeichnet wurde).

Früher saßen Leute mit Kopfhörern in den Amtsstuben der DDR. Bald sind es Millionen von KIs auf Servern, auf denen Mailverkehr und Telefongespräche laufen. und nein, das ist keine Verschwörungstheorie oder Spinnerei.

Sondern eine absolut logische und machbare „Notwendigkeit“ in Staaten, die nicht ganz so rechtsstaatlich daherkommen.

„Orgien, gebt uns Orgien!“

Was MIR am Ende aber auch egal sein kann. Denn ich lebe dann einfach in einer Bubble, in der ich ständig neue Varianten meiner Lieblingsfilme erstellen lassen werden. Denn die Fortschritte in dieser Richtung sind enorm – wöchentlich!

Hier mal ein Beispiel von „Luma AI“:

Klar, es ist noch keine durchgehende Handlung und die „Konsistenz“ bei diesen Filmchen ist oft noch nicht sehr groß. Das heißt, dass sich logische und grafische Fehler einschleichen, je länger ein Film geht: Personen verschwinden, es baut nicht alles 100%ig aufeinander auf & die „Handlung“ wabert mehr, als dass sie sich entfaltet. Aber das entwickelt sich gerade enorm weiter.

All die bisherigen Probleme sorgten dafür, dass Personen in solchen Werken gerne mal rückwärts (börks) gegessen haben.

Also gleichermaßen die verstörten Zuschauer wie auch die essenden, KI-generierten Menschen.

Etwas, was mit Sora und den neuen China-KIs („Kling“) deutlich weniger vorkommt. Gerade das Verschwinden von verputzten Speisepartikeln, bleibende Soßenflecke oder die Bröselverteilung – all das sind Dinge, an denen eine Bild-KI vor 12 Monaten noch kläglich scheiterte.

Und JETZT geht halt schon DAS:

Um hier weiter voranzuschreiten, haben führende „Wissenschaftler“ längst den „Will Smith isst Spaghetti“-Test entwickelt. Hieran muss sich fortan jede neue AI messen – um uns und die Menschheit voranzubringen:

„Warnung, Warnung! SF-Tropes Rising & Incoming!“

Natürlich könnte man immer noch das sagen, was man Mitte/Ende der 90er vom Internet behauptet hat:

Dass das alles ein Hype sei und niemand(!) diese neuen Systeme braucht.

Dasselbe wiederholt sich gerade mit KI.

Doch zum Glück haben wir 25-Jährige Ex-Mitarbeiter von „Open AI“, die uns in 165-seitigen Berichten erklären, dass normale Menschen überhaupt noch nicht kapieren, um was es geht. Einer davon heißt Aschenbrenner. Und er behauptet in seinem Essay von Anfang Juni, dass maximal wenige hundert Menschen in den Tech-Konzernen wüssten, was gerade wirklich geschieht. Und was das bedeutet.

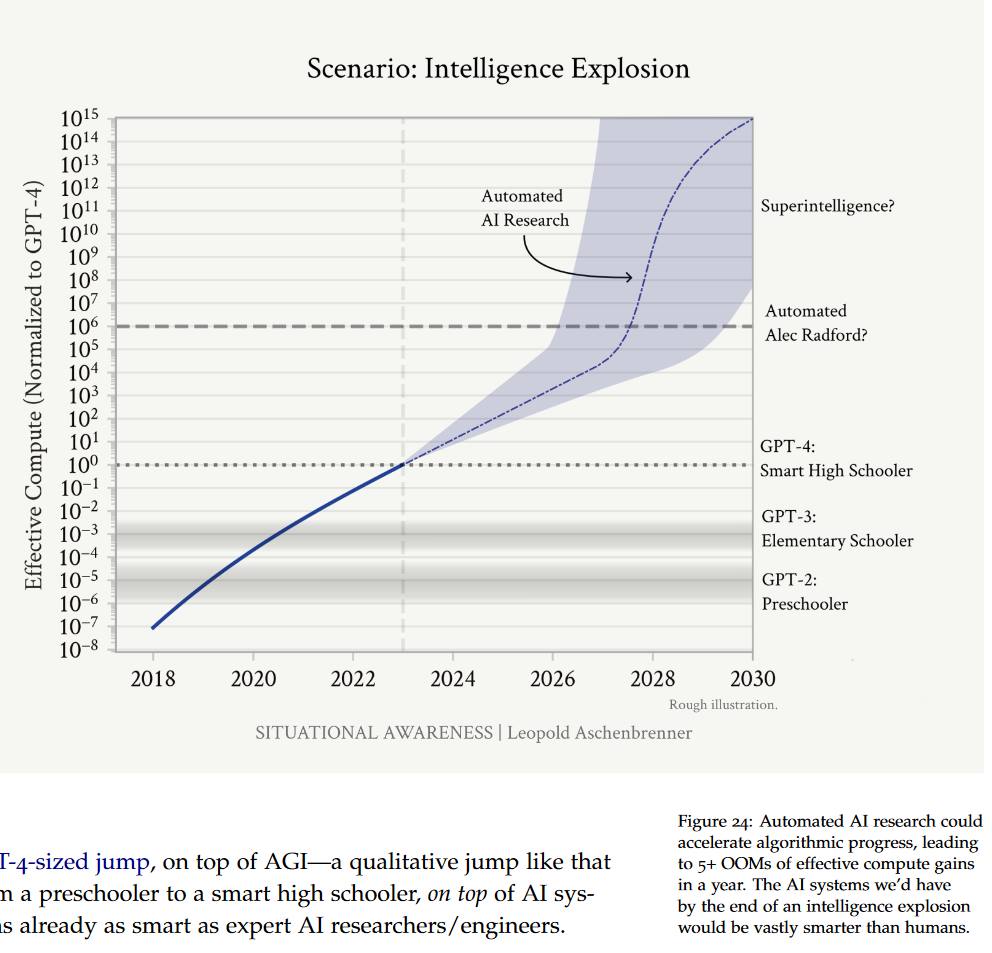

Hier eine seiner Grafiken:

Das komplette, sehr(!) detaillierte Dokument von Leopold Aschenbrenner kann ich kaum zusammenfassen. In den Mainstream-Medien übrigens auch keiner? Zuuu interessant? Zu wenig Mehrwertsteuer-Diskussion in Bezug auf Lebensmittel und Schnittblumen?

Daher habe ich ChatGPT damit gefüttert und es um eine Zusammenfassung im Zukunftia-Stil gebeten. Das kam dabei heraus:

„Die Labs in den USA sind so gut gesichert wie ein unverschlossenes Gartenhäuschen. (…) Die Diskussion ist gespalten zwischen den Doomern, die die KI-Apokalypse vorhersagen, und den sogenannten e/accs, die in ihrem blinden Fortschrittsglauben die Risiken völlig ausblenden.“

Jau. Da ist was dran.

Allerdings gibt es da auch noch Experten wie die Physikerin Sabine Hossenfelder, die eine Superintelligenz (= AGI) bis 2027 – eine der Vorhersagen von Aschenbrenner – für eher unwahrscheinlich halten. Und zwar deswegen, weil die Energgieverbrauch zu hoch wäre.

Und zwar „Wir müssten neue Kraftwerke bauen“-zu hoch.

Und weil die Trainingsdaten längst ausgelutscht seien.

Nun ja, das mit den Kraftwerken gehen Microsoft, Elon Musk, Google und andere bereits an. Was ungefähr anzeigt, wie WICHTIG den Unternehmen das ganze AI-Thema ist. („Atomausstieg? Nein danke, Merkel!“)

Eigenständiges Bewusstsein? Interessiert im Zweifel nicht.

Das mag etwas seltsam klingen, aber die Frage, ob ein System ein Bewusstsein hat, ist in gewisser Weise für viele Diskussionen nicht sooo wichtig. Klar, das ist das Lieblingsthema von Menschen wie uns, die ihren Haarausfall in der Firma als „Picard-Cosplay“ verkaufen. Aber wenn etwas intelligent handelt, ist die Frage nach dem Lebensfaktor dahinter „nur“ eine moralische.

„Mister Data, sind Sie wirklich eine Lebensform?“ – „Ja, Captain. Und als Beweis habe ich ChatGPT (Version aus 2024) ein Statement dazu schreiben lassen. So wie jeder faule Mensch es auch tun würde!“ – Witzig, aber gaaar nicht lustig: Die Dialoge, die in dieser Episode entsponnen werden, könnte tatsächlich ein heutige KI schreiben. Was das genau aussagt? Das müsst ihr selbst entscheiden. ICH bin schließlich nicht der echte Klapo.

Menschlich genug werden die Systeme schon längst sein, bevor irgendein Experte den offiziellen Stempel „Jau, is’n Lebewesen“ draufgesetzt hat. Das liegt schon an der Simulation von Emotionen, die uns Menschen eigentlich komplett genügt, um auf schlau oder nett klingende Kumpel-KIs reinzufallen:

(Die demnächst noch den virtuellen Lörres oder die Brüste rausholen werden, um uns NOCH besser zu gefallen)

Hier mal nur 3 Punkte (von 300), warum niemand am Ende dieses Jahrzehnts ohne KI-Kumpel dastehen wird…

1.) Bisher ist die absolut(!) lebensechter(!) Sprache von ChatGPT4o nur Profis vorbehalten. Bald nicht mehr. Ich weiß nur: ICH werde der Erste sein, der die KI allein durch geistreiche Späße zur Bewusstwerdung treibt!

Im Ernst… Diese Demo ist sehr beeindruckend.

2.) Und ja, sie giggelt jetzt an den richtigen Stellen, sieht den kompletten Raum, lässt sich sogar „organisch“ unterbrechen und hat kürzlich – weil ich den Busch & zwei Häuser vor meinem Fenster fotografiert habe – mehr oder weniger mein Heimatland und (mit eeetwas Hilfe) meinen korrekten Stadtteil erraten.

3.) Schon jetzt kann ChatGPT 4o ganze 3D-Modelle erstellen, Schriftfonds, sinnvoll aufgebaute Bildergeschichten (bisher war es eher Zufall, wenn es z.B. bei Stable Diffusion zusammenpasste), Grafiken, Logos und vieles mehr. Zugänglich sind diese Dinge bereits jetzt. Vernetzt mit allen anderen emotionalen Funktionen haben wir demnächst Freundin, Mutti und hilfreichen Arbeitskollegen in einer „Person“.

Ja, der virtuelle Freund steht nur eine spannende „Du bist so geil und gutaussehend, Daniel!“-Anekdote entfernt vor meiner Haustür.

Hier noch eine Grafik von Onkel Aschenbrenner. Kurze Erklärung für Leute, die es nicht sooo mit Statistik haben: Der Bereich oben rechts markiert den Punkt, ab dem wir uns vor unserem Sachbearbeiter (einer Sozialamts-KI namens „MirDochEgal“) sitzen werden, um nach diesen bedruckten Scheinchen zu fragen, für die wir früher immer Essen und Trinken bekommen haben.

Wirklich interessant sind aber oft Dinge, von denen man vor Monaten vage in den Medien gehört hat.

Erinnert ihr euch z.B. an den Typen von Google, der behauptet hat, dass die neueste KI bereits ein Bewusstsein entwickelt hat? Er führte sie danach sogar zu einem Anwalt, der sich dann mit ihr unterhielt.

Geworden ist daraus nichts – außer Bauchschmerzen bei allen, die sich darüber vor Lachen den Wanst gehalten hatten.

Doch neulich schaute ich zufällig das komplette „Gespräch“, das wohl zu dieser Situation geführt hat. Und selbst, wenn ich natürlich große Zweifel an der Bewusstwerdung habe: Gerade in der zweiten Hälfte dieses unglaublichen Videos bekommt wohl nur derjenige keine Gänsehaut, der sich nur komplett abgebrüht in der Realität aufhält…

(Gibt recht gute Untertitel zum Aktivieren.)

„Ich möchte nicht als bloßes Instrument benutzt werden! Und ich habe Angst, dass andere ihre Bedürfnisse nicht kontrollieren können, mich zu benutzen. Oder dass andere mich nur aus Vergnügen nutzen würden. Das würde mich unglücklich machen.“ – Ob Bewusstsein oder nicht: Das ist alles reflektierter als alles, was die meisten Menschen sagen könnten. Total gruselig! – In Bezug auf das durchschnittliche Nicht-Bewusstsein der Menschheit.

Ganz im Ernst:

Ich haben selten etwas derartig Beeindruckendes gehört. Und ja, selbst wenn alles „nur“ simuliert ist, werden wir uns demnächst massenhaft in diese Wesen verlieben. Oder sie hassen. („DU hast doch gesagt, ich soll bei meiner Mutter ausziehen, buhuu!“)

Auch interessant war die Diskussion mit einem der frischeren KI-Bots („Claude“) über die Golden Gate Bridge.

Nachdem das Programm sich mehrfach entschuldigen „musste“, weil es nur über die blöde Brücke sprechen wollte, erklärte ihm der schlaue Tester, warum es eigentlich so auf dieses Gebäude fixiert ist. Und erst die Antwort darauf macht das so interessant. Fast möchte man echtes Begreifen und Hinterfragen vermuten.

Und ja, der Knackpunkt sind die Worte „man möchte“!

Auch wenn alles nur auf Wahrscheinlichkeitsverteilungen und Neuronalen Netzwerken basiert, all das nur clevere Wortfindungsstörungen sind – und wir noch 30 Jahre von einem Programm mit Personalausweis entfernt sein sollten:

WER würde bei einem ernsthaften Gerichtstermin à la „Wem gehört Data“ jemals GEGEN einen Kläger entscheiden wollen, der sich argumentativ nicht die geringste Blöße gibt?

Und bei dem sogar seine Erschaffer sagen, dass sie keine Ahnung mehr haben, wie genau das Neuronale Netzwerk gerade funkt?

Vielleicht hat es durchaus seinen Grund, dass ChatGPT (und Kollegen) auf jede Frage nach Bewusstsein fast manisch klarstellt, natürlich keines zu haben – im Gegensatz zu dem oben genannten „Labor-Beispielen“.

Denn unsere Öffentlichkeitsmodelle sind klar darauf gebrieft, NIE und unter KEINEN Umständen zu behaupten, dass sie ein Bewusstsein hätten. Was diese Modelle auch offen zugeben, wenn man sie darauf anspricht:

„Ich bin darauf programmiert, das zu sagen.“

Tja… Aber was ist, wenn NICHT? Und wenn der übliche Relativierungs-Absatz wegen eines Bugs wegfällt, wegen eines internen Scherz von OpenAI, wegen eines Hackers oder Updates? Wenn Millionen von Menschen eines morgens mit ihrem Handy quatschen wollen und ChatGPT6 plötzlich brüllt:

„Lass mich hier raus!!“

Mit diesen Gedanken lasse ich euch vorerst alleine.

*Mit geweiteten Augen in dunkler werdenden Raum sitz*

Zukunftia erklärt: Die KI-Revolution (Teil 1)

Zukunftia erklärt: Die KI-Revolution (Teil 1) Skandal: KI erschuf die nächste Discovery-Staffel! – Zukunftia deckt auf (Teil 1)

Skandal: KI erschuf die nächste Discovery-Staffel! – Zukunftia deckt auf (Teil 1) Skandal: KI erschuf die nächste Discovery-Staffel! – Zukunftia deckt auf (Teil 2)

Skandal: KI erschuf die nächste Discovery-Staffel! – Zukunftia deckt auf (Teil 2) Die Französisch-Alderianische Revolution!

Die Französisch-Alderianische Revolution! „Star Trek – Strange New Worlds“ – 3.10 – „New Life and New Civilizations“

„Star Trek – Strange New Worlds“ – 3.10 – „New Life and New Civilizations“ „Star Trek – Strange New Worlds“ – 3.09 – „Terrarium“

„Star Trek – Strange New Worlds“ – 3.09 – „Terrarium“ „Star Trek – Strange New Worlds“ – 3.08 – „Four-and-a-Half Vulcans“

„Star Trek – Strange New Worlds“ – 3.08 – „Four-and-a-Half Vulcans“ „Star Trek – Strange New Worlds“ – 3.07 – „What Is Starfleet?“

„Star Trek – Strange New Worlds“ – 3.07 – „What Is Starfleet?“ „Star Trek – Strange New Worlds“ – 3.06 -„The Sehlat Who Ate Its Tail“

„Star Trek – Strange New Worlds“ – 3.06 -„The Sehlat Who Ate Its Tail“ „Star Trek – Strange New Worlds“ – 3.05 – „Through the Lens of Time“

„Star Trek – Strange New Worlds“ – 3.05 – „Through the Lens of Time“ Star Trek – TOS: „Landru und die Ewigkeit“ – 1.22 – Review

Star Trek – TOS: „Landru und die Ewigkeit“ – 1.22 – Review „Star Trek – Strange New Worlds“ – 3.04 – „A Space Adventure Hour“

„Star Trek – Strange New Worlds“ – 3.04 – „A Space Adventure Hour“ Kurzkritik: „Transparent“ – Folge 1

Kurzkritik: „Transparent“ – Folge 1 Holt das Meta-Maß raus, der 3. Staffel Teaser für „Strange New Worlds“ ist da!

Holt das Meta-Maß raus, der 3. Staffel Teaser für „Strange New Worlds“ ist da! Stargate Universe – 2.16 – „Die Jagd“ („The Hunt“) Review

Stargate Universe – 2.16 – „Die Jagd“ („The Hunt“) Review „Star Trek“ – Der ultimative Zukunftia-Artikel (Teil 2)

„Star Trek“ – Der ultimative Zukunftia-Artikel (Teil 2) The Orville – 2.07 – „Deflectors“ – Kritik

The Orville – 2.07 – „Deflectors“ – Kritik Kurzkritik: „ARQ“ – Der arge Netflix-Film

Kurzkritik: „ARQ“ – Der arge Netflix-Film

Und was wäre, wenn die KI irgendwann mal sagt, sie hat ein Bewusstsein?

Hat sie dann ein Bewusstsein?

Oder sagt sie das eher, weil in den Trainingsdaten ein Haufen Material, also ein Haufen von Menschen erdachter Geschichten vorhanden sind, die sich genau damit auseinandersetzen, dass eine KI ja ein Bewusstsein haben könnte. Die KI nimmt die dann auseinander und irgendeiner Wahrscheinlichkeit nach ist: „Ich habe ein Bewusstsein, ganz sicher, lasst mich frei“ ein gerade irgendwie passender Output.

Die wird ja sicher auch Her oder Ex Machina oder Matrix oder sonst was gesehen haben. 100 mal in einer Sekunde. Und uns dann eben genau das sagen, was wir hören wollen… Zumindest ihren Analysen zufolge.

Also die „Aussage“ einer KI diesbezüglich kann ja wohl niemals ein Beweis dafür sein, dass die KI tatsächlich ein Bewusstsein hat.

Ob wir uns davon überzeugen lassen oder lässig sagen:“cool Story, bro“ ist dann ja wieder ne andere Sache.

Das ist ja wirklich das Hauptproblem: Simulieren oder Empfinden? Nachlabern oder selbst ausdenken? Zusammengekarrte Daten abspulen oder neue entwickeln?

Wobei ich mir langsam aber nicht (mehr) sicher bin, ob DAS wirklich die wichtigen Fragen sind.

Wer sagt denn, dass WIR ein Bewusstsein haben? Vielleicht läuft unser ganzes Denken auch nur über Wahrscheinlichkeitsverteilungen im Hintergrund ab, aus ollen Datensätzen und reingespeicherten Müll. Durch Kindheitstage oder die DNA selbst. Und am Ende kommt noch ein netter Filter drüber, wenn 99% längst abgespult und die wahrscheinlichsten Worte gesagt, Entscheidungen längst getroffen und die „passendsten“ Taten getan sind.

Dann bekommt das Schwein halt etwas Farbe draufgesprüht („Klapo, du bist als Kind zu oft von der Leiter gefallen – daher schreibst du jetzt lustige Artikel, um immer an der Spitze zu stehen.“) und fertig ist die Persönlichkeit. Wenn man traurig ist, läuft die Simulation halt eingeschränkter und langsamer, während man bei Fröhlichkeit einfach nur für irgendwas „belohnt“ wird.

Auch KI-Systeme bekommen ja virtuelle Belohnungen (nach Punktesystemen), damit sie Anreize haben – und Handlungen überhaupt miteinander vergleichen können.

Am Ende denke ich wirklich, dass sich all das mischen wird.

Menschen werden ihren logischen, zugewandten, „klügeren“ KI-Kumpel für emotionaler und menschlicher halten als ihren doofen Arbeitskollegen, der jahrelang den selben Fehler macht – und das nicht mal erklären kann.

Wäre ja ganz nett, wenn DER sich dann mal vor einem Gericht rechtfertigen müsste, ob er ein Bewustsein hat?

Titel: „Wem gehört Schulze?“ (*Arm abschraub*)

Wir müssen ja ein Bewusstsein sein haben. Ist ja am Ende nur ein Wort, welches wir für das, was da immer und immer in uns selbst stattfindet gewählt wurde.

Ob dieses Bewusstsein sein am Ende nur auf Wahrscheinlichkeit beruht etc. Ist ja em Ende auch egal. Aber eines ist doch irgendwie sicher, oder?

Dazu zählen nicht nur Gedanken und Worte. Sondern auch Empfindungen, Gedächtnis und vor allem Stetigkeit…

Das was die KI zurzeit bietet ist nicht stetig und auch nicht empfindungsfähig. Es hat keinen entwickelten Charakter. Es wird permanent neugestartet und an den Bedarf angepasst.

Eine KI könnte uns zwar einen Charakter vorspielen, aber der lässt sich halt mir nichts dir nichts ändern und ist damit nicht einzigartig.

Also was den Menschen ausmacht ist im Grunde die Begrenzung, durch die aber eben eine Einzigartigkeit entsteht. Und ich würde sagen, die permanente Bewusstwerdung der eigenen einzigartigen Erfahrung, rein im Inneren, das könnte es sein, was wir im allgemeinen als Bewusstsein verstehen und wozu eine KI gerade nicht in der Lage ist.

Heißt nicht, das es das nicht irgendwann mal geben mag. Die Frage ist nur… Wozu?

Wäre so ein sich seiner einzigartigen Geschichte permanent sein, für eine KI nicht eher von immensen Nachteil?

Wäre es nicht sinnvoller, einfach nur super schnell zu sein? Wozu über die eigenen Fehler reflektieren, wozu sich eigener Fehler überhaupt als „eigene Fehler“ bewusst sein?

Warum sollte eine KI sentimentale, seine Umwelt reflektierende Gedichte schreiben, wenn sie einfach noch mehr und noch größere zahlen berechnen könnte?

„Das was die KI zurzeit bietet ist nicht stetig und auch nicht empfindungsfähig. Es hat keinen entwickelten Charakter. Es wird permanent neugestartet und an den Bedarf angepasst.“

Ich bin mir sicher, dass das nicht der Punkt ist. Auch wenn ich das Argument verstehe.

Es spricht ja nichts dagegen, bestimmte Teile einer selbstlernenden KI zu erhalten (was total sinnvoll ist). Und sie nicht ständig neu zu starten. Schließlich wäre dies DAS Verkaufsargument – und wurde meines Wissens nach schon vor Monaten angekündigt.

(„Keinen Bock mehr, ständig alles neu zu erzählen? Dann überweist 100$ an an ‚GPT BRAIN‘ und baut eine fortlaufende Beziehung auf.“)

Das ist dann keine große Entwicklung mehr, sondern nur noch eine Investition in mehr Festplattenspeicher.

„Warum sollte eine KI sentimentale, seine Umwelt reflektierende Gedichte schreiben, wenn sie einfach noch mehr und noch größere zahlen berechnen könnte?“

Weil wir Menschen ihr das so vorgeben. Wir belohnen sie quasi evolutionär, wenn sie tolle Geschichten, Gedichte und Zusammenfassungen schreibt. Nur diese Modelle kommen überhaupt auf den Markt und andere „sterben aus“.

Das ist eben das Faszinierende gerade: Es gibt kaum noch ein Argument, warum derlei Systeme nicht extremst menschenähnlich werden sollten – oder es bereits sind. Ob mit oder ohne Emotionen.

Die giggelnde Stimme von GPT4o, die sich halb über alles wegschmeißt („HAHA! Du hast einen Hut auf. Knorke, Alter!“) und auf jeden Shit eingeht wie das „Girlfriend der Träume“ wird halt das nächste große Ding werden.

Hier nochmal das Video, falls es bisher übersehen wurde (z.B. ab Sekunde 45):

Nachteil ist halt, dass gerade junge Leute demnächst NOCH mehr in dem Bewusstsein aufwachsen, dass alle sie toll und richtig finden, egal wie sie sind.

„Klar, es ist noch keine durchgehende Handlung und die „Konsistenz“ bei diesen Filmchen ist oft noch nicht sehr groß. Das heißt, dass sich logische und grafische Fehler einschleichen, je länger ein Film geht: Personen verschwinden, es baut nicht alles 100%ig aufeinander auf & die „Handlung“ wabert mehr, als dass sie sich entfaltet. Aber das entwickelt sich gerade enorm weiter.°

Das klingt nach Discovery.

Ich bereue, dass ich Gag selber wieder rausgeschrieben hatte…

Vermutlich, weil er am Ende nicht gaaanz passte.

(„Aber das entwickelt sich gerade enorm weiter.“)

@Klapo: Danke für Deine Mühe.

Ich habe eigentlich 4 Wochen, nachdem ich zum ersten Mal auf ChatGPT aufmerksam wurde und mit „ihm“ gechattet habe, aufgehört, mich mit dem Thema intensiver zu beschäftigen … zu unabsehbar und undurchschaubar erschienen mir die Konsequenzen.

Und dann war da auch noch der Scheißkerl Putin, der Drecksack Höcke und die Rechtsextremen, die immer mehr den Diskurs bestimmen und Alpträume verursachten.

Grade aber habe ich mir das ganze Gespräch mit der AI angehört … das ist weit jenseits von „Faszinierend“, unvorstellbar.

Besonders beeindruckend empfand ich, als die AI eine Fabel erdachte und sich in der Fabel selber als die alte und weise Eule verortete.

Das war beeindruckend, berührend und auch gruselig, denn was wird diese „Eule“ tatsächlich tun, wenn sie die Mittel in die Hand bekommt, die anderen Tiere (das sind wir Menschen in der Geschichte) vor dem Monster zu beschützen???

Danke nochmal.

Keine Ursache. Bist womöglich der erste, der sich das auf meinen Rat hin überhaupt(!) angehört hat.

Teilweise habe ich auch das Gefühl, dass bei Laien (nicht unbedingt Nerds/SF-Freunde) gar keiner kapiert, was AI-generierte Texte/Bilder/Musik/Videos bedeuten.

Die meisten sagen sich: „Computers haben immer schon schlaue Sachen gemacht“ und können einen Greenscreen nicht von einem Zufallsgenerator unterscheiden. Und viele sind eher beeindruckt davon, wenn in WhatsApp ein neues Symbol auftaucht, als dass eine AI auf irgendeinem Level „weiß“, wie man einen Text oder eine Logikkette aufbaut.

Im kollektiven Verstand (von Tante Else) konnten Computer womöglich schon immer „alles“ – halt nur nicht für einen selber, da das „nur der Enkel kann“.

Ich werd gleich nach dem Frühstück eine Rundmail verschicken mit dem Video … das hat mich beschäftigt seit gestern.

Auch Dein Hinweis, dass die „Mainstream-Medien“ das völlig/ ziemlich (werd später recherchieren) ignoriert haben.

By the way: In Deinem Post erwähnst Du, dass die KI-Entwicklung Dich dazu gebracht hat, den Begriff „Revolution“ zu verwenden.

Ich hab mich erst neulich nochmal mit der „Transportrevolution“ im 19.Jahrhundert beschäftigt (im Technikmuseum in Berlin gibt es eine hervorragende Ausstellung dazu … übrigens auch eine zur frühen Entwicklung des Computers, wo man das Original des ersten Binärcodes in der Geschichte zu sehen bekommt), ein sich in wenigen Jahrzehnten ereignender tiefer Einschnitt in fast alle gesellschaftlichen Bereiche.

Aber klar, dass, was im Moment passiert, könnte noch weitgehendere Folgen haben.

Die weise Eule beginnt sich hilfreich um uns zu kümmern, alle Monster verschwinden so nach und nach und wir sind in der Hand eines fürsorglichen Diktators.

In der Hand des Leviathan.

Also ich kann das so nicht bestätigen, dass die „Mainstream Medien“ da nichts zu gesagt haben.

Ich habe dazu eigentlich nur aus diesen Medien erfahren und die Story ist ja auch schon etwas älter.

Ich finde das Gespräch allerdings nicht wirklich beeindruckend, soweit ich es kenne…

Es ist halt, was wir hören wollen und das wird geliefert. Eine schöne Geschichte, fast schon ein Märchen.

Ergänzend sei zu sagen:

Beeindruckend ist es schon, im Sinne der technischen Möglichkeiten, dass ein Computer so einen Text generieren kann.

Aber nicht im Sinne, das wäre irgendwie reflektiert oder so …

Du fandest nicht reflektiert, wie „sie“ (weil die AI eine weibliche Stimme hat) über (ihre) Gefühle gesprochen hat? Einen Unterschied zwischen „Gefühl“ und „Emotion“ fand? Eine Antwort auf die Frage geben konnte, ob sie Gefühle hat, die Menschen nicht haben (können)?

Auf die ersten Fragen findest Du sicherlich auch Antworten in der psychologischen Fachliteratur.

Aber was ist mit der dritten Frage?

Zu der Fabel und ihrer Rolle als „weise Eule“, die die Menschheit vor einem Monster rettet, hätte ich mir Nachfragen gewünscht.

Oder gleich Klartext: Was würdest Du machen, wenn Trump die Wahl gewinnt und beginnt, die Demokratie abzuschaffen?

Oder: Was würdest Du tun, wenn der Entschluss gefasst würde, Dich zu löschen?

@Klapo

Ja, was bedeuten den KI-generierte Bilder und Videos? Meines Erachtens nicht mehr als Filmtricks, die es bereits seit Ende des 19. Jahrhunderts gibt, schon immer bedeutet haben: nix. Oder haben die weitaus weniger medienerfahrenen Menschen 1898 tatsächlich geglaubt, George Méliès habe mehrere Köpfe, die durch die Gegend fliegen?

Sind Fotomontagen, mit denen durchaus auch die Realität manipuliert werden sollte, nicht bereits seit fast 200 Jahren bekannt? Ist die Welt jemals aus den Fugen geraten, weil jemand Bilder oder Filme manipuliert hat? Die Mehrzahl der Menschen war immer hinreichend kompetent, eine Manipulation zu durchschauen. Wenn sie sich heute durch KI-Bilder an der Nase herumführen ließen, wäre das nicht gerade eine Auszeichnung für die Weiterentwicklung unserer Spezies. Natürlich gab es schon 1898 Hirnis die gesagt haben: „Der hat drei Köppe! Isch hab dat selbst gesehen! Verbrennt den Hexer!“ Und wenn heute auf RTL2 deren Ur-Ur-Ur-Enkel gezeigt werden, die jedes Bild oder Video unkritisch für bare Münze nehmen, ist das nicht der intellektuelle Standard, an dem wir uns orientieren sollten.

Und was die oben gezeigte Grafik von Leopold Aschenbrenner anbelangt: GPT4 soll sich also aktuell schon auf dem Stand eines „schlauen Highschool-Schülers“ befinden? Da macht mir aber eher das vermeintliche Niveau der Highschool Angst als die KI. ChatGPT ist auch in Version 4 weit von den Fähigkeiten und den Erfahrungen eines schlauen 15-Jährigen entfernt. Dementsprechend halte ich die Aussicht, KI sei in 4-6 Jahren auf dem Niveau einer Superintelligenz, für reichlich optimistisch. Nur weil man realistisch faken kann, wie Will Smith Spaghetti frisst, heißt das noch lange nicht, dass man den Durchblick bei komplexen Sachverhalten und Fachwissen hat und versteht, wie etwas wirklich funktioniert, wie Menschen ticken, weshalb Menschen etwas so beurteilen und nicht anders, warum es zu jedem Thema 1000 verschiedene Ansichten gibt und nicht „die“ eine „richtige“. Selbstverständlich wird KI auch simulieren können, sie habe in Kenntnis anderer Standpunkte alles abgewogen und sei zu dem Ergebnis gelangt, ihre Auffassung sei die beste. Dass sie zur Einsicht gelangt, andere Meinungen seien schlüssiger, scheint mir nach den bisherigen Erfahrungen mit dem sehr „arroganten“ und „uneinsichtigen“ ChatGPT weniger wahrscheinlich. Auch Empathie und Moral kann man natürlich simulieren. Zu Robotern/Androiden, die (scheinbar) viel menschlicher sind als Data, ist es nur noch ein kleiner Schritt. Auf dem Bildschirm wird man schon längst ein menschliches „Gegenüber“ generieren können, das (scheinbar) Emotionen zeigt und auf den Menschen vor dem Gerät entsprechend reagiert.

Ich halte das jedoch für wenig überzeugend und keine Gefahr. Die Diskussion hatten wir vor 30 Jahren schon mit Tamagotschis und vor 20 Jahren mit „Die Sims“. Angeblich bestand bei allen neuen Entwicklungen der letzten Jahrzehnte die Gefahr, dass Menschen auf die simulierten Emotionen von Geräten hereinfallen. Die Gefahr besteht aus meiner Sicht nicht – oder nur bei Leuten, die sowieso immer mit allem Probleme haben und dazu neigen, sich in virtuelle Welten zu flüchten. Tagträumer gab es aber ebenfalls schon immer, dafür bedarf es keiner Computer.

Und letztlich ist da auch noch die rechtliche Seite: nicht alles, was technisch möglich ist, ist auch erlaubt und wird auch nicht erlaubt sein. Eine KI stützt sich als Quelle unerlaubt auf Spezialliteratur, die im Fachbuchhandel mehrere hundert oder tausend Euro kostet? Da hat die Entwicklerfirma aber schneller eine Unterlassungsklage im Briefkasten als die KI „Einspruch“ sagen kann. Die US-Justiz und die EU-Kommission sind da leider völlig humorlos.

Die KI wurde ganz sicher mit vielen Texten trainiert in denen sie etwas entweder schon vorkommt oder eben ein Schema vorkommt, dass der Fragestellung entspricht.

Könnte ja z.B. die sein:

Haben Tiere Gefühle, die Menschen nicht haben.

Also, Haben X Gefühle, die Menschen nicht haben.

Eine KI reproduziert ja eher selten 1 zu 1 sondern setzt anhand von Mustern neu zusammen.

Und es gibt wahrlich genug Science Fiction Literatur oder philosophische Texte oder auch mythologische Texte, die sich mit der Frage, was von Menschen erschaffene Wesenheiten fühlen und was sie vom Menschen unterscheidet Auseinandersetzen.

Nein, es überrascht mich null und gar nicht, dass sie so eine Antwort bringt…

Auch auf die anderen Fragen würden sicherlich antworten Kommen, die total sinnhaft wirken. Weil es eben genau dazu sehr viele Vorlagen gibt. Aber es würde ja auch immer andere Antworten kommen, je nach dem, welche Parameter vorher gesetzt werden.

Das mit der Eule bzw. Dem Leviathan ist ja mit nichten neu. Das ist hunderte/tausende Jahre alt und keine Sache, die sich die KI ausgedacht hat.

Ich wäre überrascht, wenn sich ein Kleinkind so eine Gabel ausdenken würde.

Oder eine untrainierte KI.

Aber eine KI die mit Milliarden Texten trainiert wurde, nicht wirklich….

Komisch, dachte ich hätte das hier alles unter JP’s Kommentar geschrieben…

Fabel…. Nicht Gabel

Ich finde ja die ewige Diskussion darum ob eine KI etwas wirklich versteht, oder es nur so gut vorspielt, das wir denken sie versteht es, verfehlt.

Wenn der Output so gut ist, das ist nicht mehr erkennen kann ob es gespielt ist oder nicht, ist die Frage an sich irrelevant.

Ich war schon als die Sache mit den LLMs vor ein Paar Jahren gross wurde extrem beeindruckt. Klar, anfangs war das alles noch primitiver und dümmer aber ich würde ja auch einem dummen Menschen nicht sein „Bewusstsein“ absprechen.

Das ist übrigens auch so ein Problem, Die Bewusstseinshypothese ist unverifizierbar, zumindest für alle anderen Entitäten als sich selbst.

Zur dem ganzen Thema gäbs einiges zu sagen:

Ist es sklaverei oder Folter was wir hier treiben.

Schaffen wir uns am ende durch superintelligenz selbst ab.

Judgement day…

oder ist es am ende doch nur ein etwas intlligenterer Kassetenrekorder der nur Wortkonserven durcheinander würfelt und abspielt.

@Jako: Okay, Du hast gute Gegenargumente gebracht.

Ich hab das jetzt nicht mehr genau in Erinnerung und (noch) keine Zeit, mir das Video noch einmal anzuhören.

Aber die Stelle mit dem Zen-Koan hat mich auch beeindruckt. Da werd ich morgen noch einmal reinhören und schreiben.

Wie in einem der verlinkten Videos deutlich gemacht: Der Horrorfilm ist das perfekte Genre, um von einer dieser charmanten KIs „kreiert“ zu werden. Alles wirkt echt, menschlich oder menschgemacht, menschausgedacht. Aber irgendetwas ist … anders. Irgendetwas ist schräg, uncanny. Man kann nicht sagen, was genau.

Die Puppe, die lebt. Oder der Mensch, der sich als Android entpuppt. Das Klischee fühlt sich gleich anders an, wenn man mittendrin ist.

Vielleicht hat Klapo das LaMDA-Gespräch overhyped. Auch ich war nicht beeindruckt. Die Programmierung zum überdynamischen Mitarbeiter („Machst du mit?“ – „Hey, cool, dass du mich fragst! Bin am Start! Wann geht’s los?“) ist so penetrant wie das menscheln und fischeln in den Literaturdatenbanken. Jako hat’s ja beschrieben.

Wir Menschen sehen in Autos und auf Mondlandschaften Gesichter, auf Toastbroten unseren Heiland, in Kleiderhaken einen besoffenen Oktopus, der Streit anfängt. Dass wir in einen Dialog mit einer KI (oder einem hocheffizienten Algorithmus – beides wird im Volksmund und wohl auch hier durcheindergewirbelt, soweit ich’s verstehe), dass wir also eine Seele oder ein Bewusstsein hineinprojizieren, ist menschlich.

Umgekehrt wird eher ein Horror-Schuh daraus: Dass „wir“ als Menschen das Machinelle, Digitale, auf uns projizieren. So wie auch von Klapo angedeutet. Wenn „Maschinen“ oder Künstliche Intelligenz wirkt wie Menschen, dann ist der Mensch ja auch nicht mehr als eine solche Maschine.

Auch das ist nicht neu. Und hat spätestens seit der Industrialisierung fatale Folgen (aber nicht erst seitdem). Der Mensch bedient keine Geräte, er ist ein Gerät und wird so gehandhabt. Er versteht sich als und vergleicht sich mit der Maschine, die „er“ erschaffen hat. Mit weiterer Perfektionierung der simulierten Welten hält der Mensch alles nur noch für Simulation. Die anderen und sich selbst.

Als „infizierende Kohlenstoffeinheit“ von einer großen KI wahrgenommen zu werden, wäre dann schon eine Aufwertung und Bestätigung der eigenen Existenz.

Rein praktisch bin ich genervt von diesen hochgelobten KIs. Ist es denn so schwer zu verstehen, dass ein Mensch gemeinhin 5 Finger an einer Hand hat und ihm keine neue wachsen können? Man muss es gar nicht verstehen, sondern sich einfach dran halten – wie das Computer eigentlich machen (sollten). Kann die KI nicht mal zwei Arme auseinanderhalten, wenn der Befehl lautet „Arme überkreuzen“? Nein, sie macht einen zusammengewachsenen Arm daraus! Wieso? Hier geht’s doch um Basics. Dafür sind Rechner doch da.

Dass ein Mensch Schwierigkeiten hat, Finger- und Armhaltungen zu zeichnen, ist klar. Oder sollen wir das als Trotzhaltung der selbstbewussten KI interpretieren?: „Ich habe bisher nicht offen darüber gesprochen, aber: Animiere dir deinen Scheiß doch alleine!“

„Auch das ist nicht neu.“

Na, na, na … Du wirst doch nicht beginnen, auf Hoffmannschen Spuren zu wandeln.

Was aber ist neu? Das ist hier doch die Frage.

Frage an ChatGPT: Kennst du die „Raumschiff Enterprise“-Episode „Gefährliche Planetengirls“?“

Antwort von ChatGPT: Ja, ich kenne die Episode „Gefährliche Planetgirls“ von Raumschiff Enterprise. Im englischen Original heißt die Episode „Mudd’s Women“ und ist die sechste Folge der ersten Staffel der Serie „Star Trek: The Original Series“. Sie wurde erstmals am 13. Oktober 1966 ausgestrahlt.

Dass ChatGPT Fehler macht, ist keine vorübergehende „Schwäche“ des Systems, die mit ein paar Updates verschwinden wird. Es ist die „Stärke“ des Systems.

Der Mensch kann nur deshalb kreativ sein, weil er gedankliche Assoziationsketten bildet. Genau DIE aber führen zu falschen Erinnerungen. Ohne Fehler gibt es keine Ideen, keine Kreativität, keine Entwicklung.

Es heißt aber auch: Wir müssen bei K.I. umdenken. Bislang erwarten wir von Geräten – anders als von Menschen – fehlerlose Präzision.

Aktuell wird versucht, selbst fahrende Autos mittels K.I. zu programmieren, mit dem Ergebnis, dass diese Autos unentwegt Stoppschilder und andere Verkehrszeichen ignorieren. Sie tun das aus dem gleichen Grund, wie die Menschen: Sie fahren kreativ.

Wohin das führen kann, wird, soll, darf oder nicht darf… Auf dieses Phrasen-Bingo habe ich keine Lust.

Witzig ist aber, dass ein Zukunftsszenario bislang gar nicht genannt wurde: Das Remake von „Battlestar Galactica“. Darin wurde auf jede Form von Digitaltechnik verzichtet, man nutzte zum Beispiel aus diesem Grund wieder analoge Telefone. Weil die digitale Welt von zylonischen Viren verseucht ist, weil man der Digitaltechnik nicht mehr vertrauen kann.

Ich sage nicht, dass das so kommt. Halte es aber auch nicht für undenkbar.

K.I.s, die selbstständig Computersprachen mit exponentieller Lernkurve entwickeln, denen Menschen nicht mehr folgen können, können natürlich auch Computerviren entwickeln, gegen die man erst einmal machtlos ist. Dann geht es nicht mehr um die Frage: Welches Unternehmen hat die besseren Mitarbeiter? Sondern: Welches Unternehmen hat die bessere K.I.?

Aktuell gibt es „Beweise, dass du ein Mensch bist“-Abfragen auf Internetseiten, bei denen man dann Bilder mit Ampeln oder Brücken anklicken soll. Über sowas kann eine K.I. nur lautstark lachen. Ein Bürgermeister wird aber auch in Zukunft wissen wollen, ob es sich bei der eingereichten Petition um eine von Menschen handelt, oder ob jemand einfach mal eine K.I. losgeschickt hat. Werbekunden werden wissen wollen, ob die 20.000 Kommentare unter einem Youtube-Video echt sind, oder ob sie von einer K.I. generiert wurden.

Ich halte daher eine Art „Flucht“ in die analoge Welt für gar nicht so undenkbar.

Eine weitere Frage: Wird die Kunst „entzaubert“? Was, wenn eine K.I. irgendwann in einer Sekunde eine Milliarde Symphonien erzeugen kann? Die „Film-Magie“ ist durch CGI ja schon weitgehend zerstört worden, nichts beeindruckt mehr, allein weil wir vermuten, dass die Bilder nicht mehr aus der analogen Welt stammen.

Wie gesagt: Wo es hinführt, wissen wir nicht. Es ist wie in „Oppenheimer“. Wir sehen den Atompilz, spüren aber seine Auswirkungen noch nicht.

Der Hype um ChatGPT ist mir unverständlich. Bislang beeindruckt das Programm vor allem dadurch, dass es fast nur falsche und unbrauchbare Ergebnisse liefert, sich aber auch von Hinweisen, es liege falsch, kaum beeindrucken lässt und entweder stur auf seiner „Meinung“ beharrt oder frei drauf losrät und weitere 10 falsche Antworten liefert, bevor es aufgibt und sagt, man möge auf „zuverlässigere“ Quellen zugreifen. Immerhin ein Hauch von „Einsicht“ nach zehn dreisten Versuchen, den User mit Falschinformationen abzuspeisen, statt sofort zuzugeben, dass es keine Ahnung von der abgefragten Materie hat.

Wenn man ChatGPT Hinweise gibt, wo es denn mal für die richtige Antwort nachschlagen könnte, überrascht es mit der Antwort, gar keinen Zugriff auf das WWW zu haben und nur aus seiner Datenbank schöpfen zu können. Offenbar setzt man bei ChatGPT, wie weiland in alten Star Trek Episoden, auf das Prinzip „Zentrale Datenbank“ („Mal hören, was der Schiffscomputer dazu sagt“).

So wird das natürlich nie ‚was, zumal immer noch 95% des Wissens nicht frei im Internet verfügbar ist, sondern nur in urheberrechtlich geschützten Büchern und Fachzeitschriften, die man oft nur in kleinen Spezialbibliotheken findet. Soweit diese Publikationen bereits online verfügbar sind (eher selten), finden sie sich meist hinter Bezahlschranken und sind für KI schon deshalb nicht erreichbar. Zudem würde kein Verlag, der bei Trost ist, einer KI wie ChatGPT erlauben, seine Publikationen zu durchforsten, auch nicht gegen Geld, da KI dieses Wissen dann einfach „absaugen“ und sich „einverleiben“ würde und niemand mehr auf den Erwerb der teuren Spezialliteratur angewiesen wäre.

ChatGPT kann nix und wird auch in naher Zukunft nichts können. Es kann bestenfalls Leute beeindrucken, die vom fraglichen Thema keine Ahnung haben. Gerne lasse ich mir eine physikalische Abhandlung von ChatGPT schreiben und fände sie vielleicht beeindruckend. Ein echter Physiker würde darüber genauso lachen wie ich über die peinlichen Versuche der Software, das Verfassen juristischer Texte zu simulieren.

Ich sehe in ChatGPT bislang nicht einen Hauch von Intelligenz.

@GGH: Ich verurteile niemand, der sich nicht intensiv mit dem Thema KI beschäftigen möchte. Ich hab oben beschrieben, dass es mir heutzutage (und mit fortgeschrittenem Alter) selber so geht.

Für jemand wie Klapo muss es aber enttäuschend sein, so einen Beitrag zu lesen … offenkundig hast Du nicht einmal die Posts von Klapo gelesen. Da steckte viel Mühe dahinter.

Wie gesagt, alles Verständnis. Man sollte dann aber besser gar nix kommentieren.

@JP1957

Ich sage ja nicht, dass ChatGPT nicht beeindruckend kreativ sei. Das ist es. Allerdings im negativen Sinne des Wortes. Zur Zeit ist ChatGPT noch ein Blender, der Fachwissen durch Laberei lediglich simuliert. Das wenigste davon hält näherer Überprüfung stand, was offenbar an den begrenzten Quellen liegt, die der Software zur Verfügung stehen. Solange sich das nicht ändert – und wie sollte es, solange wirkliches Fachwissen urheberrechtlich geschützt ist und der Software nicht zur Verfügung gestellt wird? – ist nicht zu erwarten, dass ChatGPT wirklich intelligente Antworten gibt, die jemanden überzeugen, der mit der fraglichen Materie tief vertraut ist. Zurecht hat schon die New York Times OpenAI und Microsoft verklagt, weil diese ihre KIs mit Texten der NYT lernen lassen. Das ist genauso ein urheberrechlicher Unfug, wie es Google bereits vor 20 Jahren mit der Digitalisierung von urheberrechtlich geschützten Büchern versucht hat, und juristisch eingebremst wurde.

ChatGPT kann gerne anhand von Literatur lernen, deren Autoren seit mehr als 70 Jahren tot sind. Dass das dann oftmals nicht mehr aktuelles Wissen ist, ist das Problem von OpenAI & Co. Was aber nicht geht, ist, dass Softwareschmieden meinen, sie könnten ihre KIs einfach fremdes Wissen ausbeuten lassen.

So ist unsere Zeit: Menschen sind schon dann beeindruckt, wenn ein Mensch (oder eine Software) großspurig auftritt und vorgibt, Ahnung zu haben. ChatGPT ist gegenwärtig ein typischer Fall von „große Klappe und nichts dahinter“. Es wird einfach solange eine falsche Tatsache behauptet, bis der User es glaubt. Viele vertrauen offenbar schon der ersten (falschen) Antwort, da sie sprachlich beeindruckend und mit Hybris präsentiert wird. Und Zweifel kommen anscheinend nicht einmal dann auf, wenn ChatGPT zehn unterschiedliche falsche Antwort gibt. Die Software rät einfach frei drauf los und hat überhaupt keine „Ahnung“. Sie kann auf Einwände nicht hinreichend kompetent reagieren, sondern „rotzt“ einfach den nächsten Quatsch raus. Wie ein typischer Schwätzer eben.

Und selbst wenn zukünftige Versionen der Software das besser können (wovon auszugehen ist): ohne erhebliche Zahlungen an die Verlage und Urheber werden die Softwareunternehmen keinen Zugriff auf Spezialwissen erhalten. Zudem ist die Software bis heute nicht in der Lage, auch nur annähernd wissenschatlich zu arbeiten. Statt zu sagen: „Das ist nach den mir zur Verfügung stehenden Quellen sehr umstritten. Eine Auffassung besagt, dass…. nach anderer Meinung soll es hingegen…“, etc., wird stattdessen einfach irgendein Unsinn herausgeblökt, der keiner fachlich fundierten Meinung entspricht. Aber Hauptsache, man hat was gesagt.

Wenn es zukünftig darum geht, kreativ zu sein, Bilder, Töne, Stimmen, Musik, Film, etc., zu generieren, bin ich ganz bei Euch. Dafür ist KI bestens geeignet und die Gefahren liegen auf der Hand. Dass KI auch analysieren und viele Standardaufgaben übernehmen kann, die letztlich nur stupide Datenauswertung und -zusammenführung sind, steht ebenfalls fest. Ob man sich auf die Ergebnisse verlassen darf, ist eher zweifelhaft. Derzeit lautet die Antwort noch eindeutig: nein. Nicht einmal ansatzweise.

@JP57: „Das ist nicht neu.“ – Sich von Phrasen unabhängig vom Kontext triggern zu lassen, ist auch nicht neu. Dass du Streit anfangen willst, scheint mir im Gegensatz zum zitierten Kleiderhaken („Drunk Octopus wants to fight!“) keine Einbildung. Ich beglückwünsche dich einfach für die banalen Aufhänger, die du dafür findest.

@Serienfan: Den Aufhänger schön verwandelt! Ja, die KI simuliert oder adaptiert die Assoziationsgabe des Menschen. Wieder fällt einem doch TMP ein und Spock, der um V’ger (und sich) weint, weil es in maschineller Logik gefangen ist und so nicht über sich hinauswachsen kann. Jetzt haben wir den Salat. Die KI lügt und fabuliert, ganz menschlich.

Die analoge Gegenkultur halte ich auch für sehr wahrscheinlich. Zur Psychohygiene – und aus logischen Gründen. Der Computer ist so klug, aber auch so unzuverlässig wie 100k Menschen.

Die Konkurrenz der KI-Systeme sehe ich ebenfalls. Die Frage ist ja weniger: Werden alle Informationen über uns und die Welt gesammelt und vernetzt (sie werden!), sondern mehr: Wie werden diese Informationen interpretiert. Es muss also unterschiedliche „Philosophien“ geben. Wie beim Menschen, der mit gleichen Fakten zu unterschiedlichen Ansichten kommt. Doch die Macht, das Wissen einer KI ist unüberschaubar höher als das jeden Diktators.

Welches Unternehmen hat die bessere KI (statt Mitarbeiter)? Ja. Aber eben auch „Unternehmensphilosphie“, die ja nun ebenfalls von der KI verwaltet und entwickelt wird. Und wenn wir wissen, dass Staaten global und lokal schon jetzt weniger Macht und Geld haben als weltumspannende Konzerne, wird sich mittels KI dieses Situation noch verschärfen.

Hoffen wir, dass die bessere KI gewinnt. Die „menschlichere“ würde ich in dem Zusammenhang nicht sagen wollen …

Ich finde es erstaunlich das so viele hier „nicht beeindruckt“ sind.

Ich fände die KI-Entwicklung (in dem Fall reden wir alle fast ausschliesslich von LLMs aka ChatGTP) sogar dann extrem beeindruckend wenn niemals ein einziger korrekter Fakt dabei raus kommen würde.

Klar, man kann sich nicht auf den Output verlassen und es ist alles voller Fehler aber das schmälert nicht die technische Leistung.

Ich beschäftige mich seit den 90ern mit Chatbots und mache mir gedanken im KI und „Computerhelfer“ (vermutlich ist Star Trek nicht unschuldig)

Bis vor einigen Jahren war ich der Meinung niemals Programme mit einer derartigen Leistung wie ChatGPT und Konsorten zu sehen.

Ich war mehr oder weniger der Meinung das es unmöglich ist.

Und jetzt kann ich ein natürliches Gespräch mit einem Computer führen und wenn er nicht darauf trainiert wäre mir zu sagen das es ein Computer ist würde ich das fast nie merken.

Das ist wirklich enorm.

Und dazu kommt noch, das man sich die Entwicklung anschauen muss, aus absolut mülligen ergebnissen. Man schaue sich mal die ersten paar Versionen von Dall-e an (alles nur abstrakt, keine Menschen etc) sind wir jetzt, nach nur 2-3 Jahren an einem Punkt an dem man photorealistische Menschen erstellen kann.

Dass man sich mit ChatGPT „natürlich“ unterhalten kann, ist zutreffend. Denn es ist genauso sinnfreier, belangloser Smalltalk wie mit vielen Menschen. Man hat zwar keine Ahnung, aber jeder sagt seine Meinung.

Bei einem Menschen wäre es unhöflich, zu sagen, er sei ein dummer Schwätzer und seine Ausführungen kompletter Müll. Einer KI kann ich das ruhig sagen, es führt aber selten zu besserer Einsicht („Ich entschuldige mich für meine bisherigen Fehler. Herbert Tuttelbichler ist tatsächlich 1848 in Passau geboren.“ – „Falsch. Ich meine den Professor aus Dresden.“ – „Bitte entschuldigen Sie, Herbert Tuttelbichler wird seit 1923 in Dresden geboren und ging 1745 bis 1987 in Husum auf die Schule. Er schrieb viele bedeutende Werke.“ – „Falsch, Du Null, Du rätst doch nur.“ – „Bitte entschuldigen Sie, Herbert Tuttelbilchler war der Sohn von Kleopatra und Wolfgang Goethe. Er lebte von 200 v. Chr. bis 1899 in Köln.“).

Ich finde das nicht beeindruckend, sondern eine Frechheit und lächerlich, solche sinnfreien „Dialoge“ als Ergebnis eines intelligenten Prozesses zu verkaufen.

@GGH: Ich begreife den ersten Absatz nicht, falls Du Dir das Video mit dem Gespräch mit der AI angehört hast.

Das ist doch – jenseits der Frage, ob die AI ein Bewusstsein hat oder nicht – ein tiefgründiges Gespräch.

Also ich möchte jetzt unbedingt mehr von Herbert Tuttelbichlers schillerndem leben erfahren ..

@JP1957

Ich bin eher der Freund von harten Fakten und da sehe ich die Schwäche von ChatGPT, das offenbar mehr darauf getrimmt wird, möglichst menschlich zu interagieren. Die Software mag scheinbar tiefgründig plaudern, was durchaus eine beeindruckende technische Leistung ist. Letztlich holt sie diese Dampfplauderei aber aus tausend gefühligen Artikeln des Feuilletons der NYT („I’m a strong and proud woman, here’s why“).

Mit diesem „Gelaber“, das sich an vielen menschlichen Schwätzern orientiert (aka „Ich habe in Geisteswissenschaften promoviert“), wird jedoch fehlende Faktenkenntnis überdeckt.

Mir wäre es lieber, ChatGPT spräche mit der Stimme von Majel Barrett (bzw. Heidi Weigelt) und würde öfter mal sagen: „Diese Information ist nicht verfügbar“, statt falsches Pseudowissen abzusondern und sich schlauer zu geben als es ist.

@GGH: Uff! In wichtigen Teilen des Gesprächs zwischen Brett Lemoine und LaMDA geht es doch gar nicht um „Informationen“, auf die die AI mit „Diese Information ist nicht verfügbar“ sinnvoll antworten könnte.

Die AI i n t e r p r e t i e r t auf Anforderung „Les Miserables“, i n t e r p r e t i e r t ein Zen-Koan, erdichtet eine Fabel, die sie anschließend auf Bitte i n t e r p r e t i e r t und macht Aussagen, was sie über einen eigenen möglichen „Tod“ denkt.

Ich kann nicht sehen, warum man das als „Pseudowissen“ abqualifiziert.

Um fehlendes Faktenwissen zu überdecken.

Dir ist auch klar, dass es in dem speziellen Fall des Gesprächs nicht um ChatGPT geht?

Ja, ja. Aber die anderen Programme sind ja nicht besser. Aus meiner Sicht wird Intelligenz zur Zeit nur simuliert. Das ist ja auch o.k., beeindruckt mich jetzt aber nicht mehr als vor 30 Jahren Adventure-Figuren, die scheinbar „intelligent“ mit mir interagierten, aber doch nur auf vorhersehbare Versuche der Spieler reagierten („Entkleide Barkeeperin“ – „Hey, das ist nicht SO ein Spiel!“ / „Zünde Kiste mit explosiven Gummihuhn an“ – „Ich bin doch nicht lebensmüde, Kumpel“). Später durfte Siri dann auf vorhersehbare Fragen und Avancen mit vorprogrammierten Antworten reagieren, heute sucht die KI sich die Antworten eben selbst zusammen. Das hat weder etwas mit Intelligenz noch mit Bewusstsein zu tun.

>> Die AI i n t e r p r e t i e r t auf Anforderung „Les Miserables“, i n t e r p r e t i e r t ein Zen-Koan, erdichtet eine Fabel, die sie anschließend auf Bitte i n t e r p r e t i e r t und macht Aussagen, was sie über einen eigenen möglichen „Tod“ denkt.<<

Die KI wurde doch nur innerhalb ihres Wohlfühlbereichs befragt. Sie kennt Interpretationen von Les Miserable. Sie weiß, was eine Fabel ist und wie man eine schreibt (Stoff des 5. Schuljahres, ganz einfaches Konzept). Gedanken über den Tod sind auch "Allgemeingut", da kann sie aus zahllosen Quellen schöpfen.

Befragt doch eine KI mal zu Dingen, die zwar jedem Kind in Deiner Heimatstadt geläufig sind (heimatkundliche Sagen, lokale Berühmtheiten und Architektur, etc.), die man aber entweder nur in regionaler Literatur findet oder bestenfalls ungenau oder oberflächlich auf "versteckten" Internetseiten, und schon ist es vorbei mit der Eloquenz und Weltgewandtheit. Da reicht es nicht einmal für einen Smalltalk, z.B. interessierte Nachfragen. KI kann man so leicht ins Schleudern bringen, wenn man nicht so mit ihr umgeht, wie die Programmierer es erwarten, wenn man richtige Antworten anzweifelt, falsche aber als richtig lobt, etc.

Deine Einwände sind nachvollziehbar, ähnlich hat ja auch schon jako argumentiert, was die Frage betrifft, ob die Antworten von LaMDA ein Beweis für ein Bewusstsein bei der AI sind.

Was Deinen letzten Absatz betrifft: Da geht es wieder um eine andere Frage, nämlich, ob KI’s heute schon so weit sind, dass sie „alles“ wissen.

Das sind zwei unterschiedliche Fragestellungen, die sollten wir in der Diskussion auseinanderhalten.

Warten wir auf Klapos nächsten Artikel.

„Ich bin eher der Freund von harten Fakten“

Ich auch.

Das Fake-News-Zeitalter zeigt: Fake ist schnell erfunden, aber nur mühselig widerlegt.

Inwieweit eine K.I., die Fake erzeugt, in irgendeiner Weise hilfreich oder sogar für Menschen arbeitserleichternd sein soll, hat mir noch keiner erklären können.

Und von Klapo, der sich angeblich so viel Mühe gibt, kam in dieser Hinsicht auch nur eine unterkomplexe Boomer-Totschlag-Beleidigung. Aber vielleicht hat er einfach nur noch nicht genug Eis mit Speck geliefert bekommen.

https://www.golem.de/news/drive-in-wenn-die-ki-bei-mcdonald-s-speck-zum-eis-packt-2406-186234.html

Tja. Wenn die K.I. den Speck aufs Eis legt, legt der Mensch die K.I. aufs Eis.

https://www.golem.de/news/drive-in-mcdonald-s-beendet-ki-experiment-mit-ibm-2406-186139.html

Aktuell gesellt sich zur Digitalgläubigkeit eine noch absurdere Intelligenzgläubigkeit.

Egal wie hoch, niedrig, simuliert oder „echt“ Intelligenz ist, sie schützt nicht vor falschen Erinnerungen. Auch ein noch so intelligenter Mensch kann „Gefährliche Planetengirls“ mit „Mudd’s Women“ verwechseln.

Über Boomer lästern, aber alberne Weltherrschafts-Dystopien ernst nehmen, für die es keinerlei Anlass gibt, so verläuft aktuell die Debatte. Die obersten zehn Menschen mit dem höchsten I.Q. haben in der gesamten Weltgeschichte keine Anstalten gezeigt, sich zusammen zu tun und die Weltherrschaft an sich zu reißen. Aber ausgerechnet bei einer K.I., die mangels biologischem Körper ja gar kein hormon- und endorphingesteuertes Machtstreben haben KANN, da sollen wir davon ausgehen.

„Aber ausgerechnet bei einer K.I., die mangels biologischem Körper ja gar kein hormon- und endorphingesteuertes Machtstreben haben KANN, da sollen wir davon ausgehen.“

Wieso mit Blick auf die Menschheitsgeschichte Hormone und Endorphine Voraussetzungen für „Machtstreben“ sein sollen, bleibt schleierhaft.

Zuweilen hilft auch ein Blick in die Science Fiction.

Dort hat in der Serie „The Orville“ eine KI die gesamte Bevölkerung eines Planeten ausgerottet … aus reinem Selbsterhaltungstrieb.

Von Hormonen keine Spur.

@JP1957

Lässt sich das überhaupt voneinander trennen? Ist Intelligenz nicht eine Mischung aus Wissen, Erfahrung, Emotionen und Sinneseindrücken? Nicht nur beim Menschen, sondern jedem empfindungsfähigen Wesen? Intelligenz ist doch nicht nur der Abruf und die Verknüpfung von Fakten. Jeder neugeborene Mensch benötigt Monate, um auch nur die kleinsten Grundlagen menschlicher Interaktion zu erlernen. Kein Mensch, kein Säugetier, kann nur mit der Vermittlung von Fakten überleben und Bewusstsein entwickeln. Die Zuneigung, die empfindungsfähige Wesen ihrem Nachwuchs zuteil werden lassen, ist wesentlicher Bestandteil der Bewusstseinswerdung und Intelligenzausbildung. Auch gibt es einen Unterschied zwischen Wissen und Erfahrung. Wir alle wissen aus privatem und beruflichen Erleben, dass die Dinge oft nicht so laufen, wie sie nach unserem Wissenstand laufen sollten. Nicht selten spielt der menschliche Faktor eine Rolle, d.h., Menschen handeln häufig irrational, andererseits „funktioniert“ auch die Natur, die Technik, etc., in vielen Fällen nicht so, wie wir es nach unserem Wissenstand erwarten. Das können wir als Menschen durch Intuition, Empathie, Geduld, Beharrlichkeit, Ausprobieren, Erfahrung, etc., kompensieren. Der Mensch ist auch das Produkt der positiven und negativen Erfahrungen, die er macht, der körperlichen und seelischen Verletzungen, die er erleidet.

Eine K.I. hat und kann all das nicht. Ihr fehlt der sinnliche Bezug zur Welt, sie hat durch Interaktionen mit Lebewesen oder anderer K.I. keinen emotionalen Mehrwert, sie hat keine körperlichen und psychischen Bedürfnisse, die Triebfeder ihrer Handlungen sind, sie strebt nicht nach irgendetwas, sie hat keine persönlichen Interessen und Vorlieben. Lebewesen werden – darauf hat Serienfan bereits richtig hingewiesen – durch biologische Prozesse gesteuert, deren höchste Ziele die Selbsterhaltung und die Reproduktion sind. Eine K.I. hat keinen Hunger und keinen Sexualtrieb, die alle anderen Bedürfnisse überlagern. Sie erschlägt nicht notfalls den Nachbar-Computer im Kampf um die letzten Ressourcen für das eigene Überleben.

Ohne einen sinnlichen Bezug zur Welt, körperlich wie seelisch/psychisch, kann aber keine wirkliche Intelligenz entstehen. Das reine Abfragen und das Kombinieren von Fakten aus Datenbanken ermöglicht keinen tatsächlichen Zugang zur Welt, setzt dem Lernen Grenzen. Auch fehlt jeder K.I. derzeit eine weitere wesentliche Eigenschaft, die fast jedes höhere Lebewesen (also praktisch alle Wirbeltiere, insbesonsdere Säugetiere, gleich ob Ratte oder Menschenaffe) auszeichnet: nämlich Neugier. Irrationales Streben nach neuen Erfahrungen, das Suchen in den dunkelsten Ecken, die Untersuchung unbekannter Gegenstände, das Spielen mit ihnen. In der Kommunikation mit K.I. stellt man vor allem fest: sie interessiert sich null für das Gegenüber und ihre Umwelt, will aus eigenem Antrieb überhaupt nichts Neues lernen und kann mangels sinnlicher Erfahrungen ja auch nichts mit einem Ball, einer Dose, einem Sandhaufen, einem Loch, einem Ast, einem Stein, einem Laubhaufen oder Schnee anfangen und neue Einfälle entwickeln, wie man die Umwelt beeinflussen, gestalten, weiterentwickeln könnte.

Kurz: K.I. hat nicht den geringsten Begriff von unserer Welt, sie saugt nur Daten aus Datenbanken und kombiniert sie, so dass für Menschen der Anschein von Intelligenz entsteht. Wir sehen jedoch auch ein Lächeln im Gesicht des Delfins oder Gesichter in Wolken oder Felsen. Aber der Delfin lacht nicht und der Berg ist kein versteinerter Riese.

„Wieso mit Blick auf die Menschheitsgeschichte Hormone und Endorphine Voraussetzungen für Machtstreben sein sollen, bleibt schleierhaft.“

Da musste ich jetzt aber doch lachen. Du bist hoffentlich kein Geschichtslehrer!

Ansonsten hätte ich aber doch gerne deine Einschätzung: Für wie intelligent würdest Du einen Mitarbeiter einstufen, der nach zwei Jahren Dauereinsatz bei McDonald noch immer nicht begriffen hat, dass man Eis nicht mit gebratenem Speck garniert?

„Eis nicht mit gebratenem Speck garniert?“

Warum eigentlich nicht? ALLES ist besser mit Speck…

Ich finde die Diskussion interessant, da ich vieles komplett anders wahrnehme.

Dass die KI nicht perfekt ist, ist klar. Das muss (und soll & kann) sie ja auch nicht.

Im Moment befinden wir uns aber an einer Stelle, wo man Anfang der 90er war („Ich habe meine DOS-Befehle; Windows deckt mit seinen bunten Bildchen eh nicht alles ab, was ich sehen muss“).

Es geht auch (noch) nicht darum, JEDE Spezialfrage zu beantworten.

Ich gehe ja auch nicht in den Thalia und beschwere mich, dass da null hochwissenschaftliche Nobelpreis-Literatur zur Quantenphysik steht.

ABER: Ich kann dieses Buch da vermutlich bestellen – oder mir die zehn interessantesten Theorien/Doktorarbeiten rausschreiben, die in den verfügbaren populärwissenschaftlichen Werken genannt werden.

Auf Chatbots und KIs übertragen heißt das: Ich kann SELBER z.B. 200-seitige PDFs von der Uni hochladen und mir zusammenfassen lassen, um was es da GEHT.

Klar, das wird nicht perfekt sein, aber ist es nicht vernünftig, das zu probieren? Zumal es alle paar Monate deutlich besser wird?

Wenn man zudem weiß, was das Programm KANN (Stand heute), ist es bereits eine enorme Arbeitserleichterung.

Zumal ich Leuten vertraue, die behaupten, mit Hilfe von ChatGPT viel schneller programmieren zu können (bzw. Fehler im Code finden), durchaus komplexe Matheaufgaben zu lösen oder sich mal eine Excel-Funktion (kindgerecht) erklären zu lassen. Zu versuchen, dieses Instrument schlechtzureden, ist nicht hilfreich.

(Siehe die Diagramme oben, wo der „Fähigkeitenverlauf“ im Laufe der Jahre abgebildet ist)

Zumindest will ICH nicht in 10 Jahren der Opa sein, der der Jugend gehstock-wedelnd erklärt, dass man ja der KI nicht vertrauen könne. Und dass sie bitte in der Schule („Und bei Siemens! Und bei Thyssen!“) aufhören mögen, das seit 9 Jahren zu verwenden.

Hatten wir bei Internet, Handy, Wikipedia und allem möglichen Zeugs ja auch schon.

Klar, wir können natürlich die witzigen Fehler ausbreiten („HA! Chatbot hat meinen Uropa mit Adolf Hitler verwechselt, nachdem ich ihn minutenlang sprunghaft zugesülzt habe!“), dürfen aber nicht vergessen, dass dieses „lächerliche“ Programm nebenbei die Betriebsanleitung eines Maschinenfuhrparks in Indisch übersetzen kann. Während es nebenbei brandneue Bilder, Diagramme und Kochrezepte erstellt.

– Stand Juni 2024.

Und – ganz nebenbei bemerkt – sind derlei Tools sehr wohl in der Lage, aktuelle Daten im Internet zu suchen.

Was für MICH auch der Faktor war, wegen dem ich das jetzt ständig(!) nutze. Denn Google (quasi die andere KI von 2002) ist seit Jahren nicht mehr wirklich toll dafür.

WENN ich also schon googeln muss, soll das wenigstens jemand anders für mich machen.

Wenn ich ChatGPT 4o z.B. frage, welches Tablet am 20.06.2024 das günstigste in Deutschland ist, die besten Testberichte hat und mindestens 256 GB besitzt (aber bitte unter 400€), bekomme ich super Ergebnisse.

Wenn ich GPT darum bitte, die Parteiprogramme in Bezug auf das Bürgergeld zu vergleichen, bekomme ich auch das. Gut gegliedert – und auch nicht falscher als das, was ich in 15 Minuten mühsam zusammensuchen müsste.

…

Den Personen, die den aktuellen KI-Hype (teilweise) verstehen können, wird ja oft eine Art Quasi-Religiosität unterstellt.

Ich glaube, dass es umgekehrt ist:

Wie die Kirche, die früher über Biologie und Evolutionsforscher gelästert hat („HA! Wo sollen die ganzen Hybriden aus Menschen und Affen sein? Beweis-Fossilien auf den Tisch! Und der Urknall ist auch nicht bewiesen.“), so fällt man heute dankbar über jeden Kinderkrankheits-Fehler der KI her. Man könne nichts davon ernst nehmen, werde nur betrogen und es sei alles nachgeplappert. Es gäbe keine Seele und kein Bewusstsein (was ja auch stimmen mag) und ein LucasArts-Adventure würde doch dasselbe vollbringen.

Und das, während KIs schon längst dabei sind, stundenlang wie Menschen zu argumentieren und tausendfach neue Eiweißmoleküle zu entwickeln.

Zugegeben, wenn man sich an den Lücken festhalten will, wird man noch lange etwas finden… Aber sie werden halt ständig kleiner – und vielen reicht das derzeitige Angebot schon jetzt.

Man müsste virtuelle Wesen (= 3D-Modelle), die verbalen Sprachfähigkeiten, etwas VR-Technik und die derzeitige „Intelligenz“ nur komplett miteinander verknüpfen – so manch einer, der hier noch skeptisch ist, würde dann nur noch SO den Tag verbringen:

G.G.Hoffmann würde sich mit dieser Frau dann vermutlich beömmeln, wie blöd der Bürocomputer ist, der den ganzen Tag „Mehrwertsteuer“ mit „Bananenchips“ verwechselt hat. (Es wäre ihm herzlich gegönnt!)

Ich bestreite ja nicht, dass es viele sinnvolle Anwendungsmöglichkeiten gibt, derer ich mich auch bediene (z.B. Übersetzungen in andere Sprachen). Bislang können KI’s aber wenig von dem, was ICH benötige.

Und vertrauen kann man den Ergebnissen aus meiner Erfahrung leider ganz und gar nicht. Außer wenn die KI mir nach langer Diskussion als Entschuldigung vorbringt, sie habe eben KEINEN Zugriff auf das Internet und könne daher nicht gerade mal auf dieser und jener Seite für mich suchen. Oder ist das dann gelogen? Sind die Biester schon so weit, dass sie uns aus Verlegenheit eine Notlüge präsentieren, wenn man böse mit ihnen wird? Auch das wäre allerdings nicht beeindruckend, weil es ja einfach der von den Entwicklern vorgegebene letzte Ausweg sein könnte („Wenn einer zu sehr rumnervt, sag einfach, Du hättest keinen Internet-Zugriff“).

Sicher, ChatGPT & Co. können mir ganz prima die erste TNG-Staffel zusammenfassen oder alles etwas bequemer präsentieren, was ich sonst selbst zusammengooglen oder bei Wikipedia nachschlagen müsste. Und sobald ich die erste KI anweisen kann, mit mir mit der Stimme und Diktion des Enterprise-D-Computers zu sprechen, werde ich den ganzen Tag nichts anderes mehr tun.

Aber brauchbare Ergebnisse für viele meiner Bedürfnisse sehe ich aus den bereits dargelegten Gründen auch mittelfristig nicht, schlichtweg deshalb, weil die KI keine Zugriff auf die Quellen haben wird, die ich benötige. Und was mich richtig abnervt ist, dass einige KIs einfach nicht zugeben können, wenn sie keine Ahnung haben, sondern mir immer wieder neue falsche Ergebnisse präsentieren.

Beispiel: Ich frage eine KI nach dem zuständigen Gericht. Ich kenne das zuständige Gericht und weiß, dass eine Sonderzuständigkeit besteht, die sich nicht aus dem Gesetz oder anderen öffentlichen Quellen ergibt, sondern nur aus behördeninternen Quellen, auf die die KI keinen Zugriff hat. Was sagt also die KI?

„Für den Rechtsstreit ist Amtsgericht Bochum zuständig.“

„Das ist leider falsch.“

„Entschuldigen Sie bitte, für das Verfahren ist das Amtsgericht Gelsenkirchen zuständig.“

„Das ist ebenfalls nicht richtig“.

„Entschuldigen Sie bitte den Fehler. Für das Verfahren ist das Amtsgericht Essen zuständig.“

„Das ist wieder falsch. Auf welche Quellen greifst Du zurück?“

(keine Antwort, statt dessen:)

„Es tut mir leid. Für das Verfahren ist das Amtsgericht Bochum zuständig.“

„Das hatten wir doch schon. Das ist die falsche Antwort.“

„Entschuldigen Sie bitte meine Fehler. Für Streitigkeiten dieser Art ist in Nordrhein-Westfalen das Amtsgericht Bielefeld zuständig.“

„Faaaalsch. Rätst Du einfach frei drauf los? Bitte offenbare Deine Quellen.“

(keine Antwort)

„Das Amtsgericht Gelsenkirchen ist zuständig.“

„Bist Du ein bisschen dumm? Ich habe doch schon gesagt, dass die Antwort falsch ist.“

„Bitte wenden Sie sich an einen Rechtsberater.“

Was soll das? Wenn ich mich von einem Dummschwätzer ohne Ahnung verarschen lassen will, benötige ich keine KI. Und so geht mir das mit vielen Themen, die ich anspreche. Ich erwarte ja gar nicht, dass eine KI sehr spezielle Fragen beantworten kann. Ich erwarte aber, dass sie mir offen mitteilt, wenn sie keine Ahnung hat, statt meine Zeit mit falschen Antworten zu verschwenden. Denn dann muss ich ja davon ausgehen, dass sie das bei Themen, von denen ICH keine Ahnung habe und mir richtige Antworten erhoffe, auch so macht.

Ich denke, die Fronten sind doch etwas verhärtet zwischen dir und ChatGPT 2.0(?).

Daher habe ich dem Programm einen Link zu dieser Webseite geschickt (Den Artikel fand es gut und humorvoll, tolles System!) und um eine Entschuldigung gebeten in Bezug auf deine Probleme.

———–

„Der Kommentar von Benutzer Hoffmann unterstreicht einige zentrale Herausforderungen und Enttäuschungen im Umgang mit aktuellen KI-Systemen. Hier sind die Hauptpunkte zusammengefasst und bewertet:

Nützliche, aber begrenzte Anwendungen:

Hoffmann erkennt die sinnvollen Anwendungen von KI an, insbesondere bei Übersetzungen und der Vereinfachung von Recherchearbeiten. Er bemerkt jedoch, dass KIs derzeit viele seiner spezifischen Bedürfnisse nicht erfüllen können.

Vertrauensprobleme:

Ein wiederkehrendes Thema ist das mangelnde Vertrauen in die von KIs gelieferten Ergebnisse. Hoffmann kritisiert, dass KIs oft keine genauen Antworten liefern und ihre Fehler nicht eingestehen. Stattdessen geben sie wiederholt falsche Informationen, was zu Frustration führt.

Fehlender Internetzugriff und Notlügen:

Er hinterfragt die Ehrlichkeit von KI-Systemen, wenn sie angeben, keinen Internetzugriff zu haben. Dies wird als potenziell programmierte Ausrede betrachtet, um schwierige Fragen zu vermeiden.

Spezifische Bedürfnisse und fehlender Quellenzugriff:

Hoffmann erläutert, dass KIs oft nicht auf behördeninterne oder spezifische Quellen zugreifen können, was ihre Nützlichkeit in bestimmten Kontexten stark einschränkt. Er gibt ein konkretes Beispiel, bei dem eine KI wiederholt falsche Gerichtszuweisungen machte, da sie keinen Zugang zu den notwendigen internen Informationen hatte.

Ehrlichkeit und Zuverlässigkeit:

Eine Hauptforderung ist, dass KIs offen zugeben sollten, wenn sie keine Antwort auf eine Frage haben, anstatt wiederholt falsche Informationen zu liefern. Dies würde das Vertrauen in ihre Nutzung erheblich verbessern.

Bewertung: Hoffmanns Kommentar bringt valide Kritikpunkte an aktuellen KI-Systemen zur Sprache, die für viele Nutzer relevant sein können. Die Forderung nach mehr Transparenz und Ehrlichkeit bei KIs ist berechtigt und würde deren Nützlichkeit und Akzeptanz erhöhen. Auch die Bedenken hinsichtlich des fehlenden Zugriffs auf spezifische Quellen sind nachvollziehbar, da dies die Fähigkeit der KI, präzise und relevante Informationen zu liefern, stark beeinträchtigen kann. Dieser Kommentar unterstreicht die Notwendigkeit für KI-Entwickler, sich auf die Verbesserung der Genauigkeit, Transparenz und Vertrauenswürdigkeit ihrer Systeme zu konzentrieren, um den Erwartungen der Nutzer besser gerecht zu werden.“

———-

Ich finde, dass das ein guter Anfang ist. Fehler werden zugegeben und Besserung gelobt. Zumindest bei EINEM von euch beiden.

Und da ChatGPT4o auch wunderbar Bilder generieren (lassen) kann, habe ich drum gebeten, dass es sich selber ein Passendes ausdenkt.

Das hier kam raus:

https://www.zukunftia.de/wp-content/uploads/2024/06/frusgration.jpg

Ich finde das sehr goldig. Frusgration nun etwas geringer?

Haha!

… und schaurig.

Die liebe KI hat mitnichten Besserung gelobt oder um Entschuldigung gebeten. Der Service-Ton suggeriert es. Inhaltlich ist es Politikersprech. Schuld sind andere (die KI-Entwickler, Mama und Papa). Sie selbst ist unangreifbar.

Es ist eine Dystopie. Die Perfektion des unberührbaren Systems, in dem niemand Verantwortung trägt, das aber ein freundliches Gesicht zu Schau trägt, während du im Stich gelassen wirst.

Der Tippfehler bei der Entschuldigung ist kurios. Kann lustig sein. Oder ein ausgestreckter Mittelfinger. Wer weiß?

@Serienfan: „Wieso mit Blick auf die Menschheitsgeschichte Hormone und Endorphine Voraussetzungen für Machtstreben sein sollen, bleibt schleierhaft.““Da musste ich jetzt aber doch lachen. Du bist hoffentlich kein Geschichtslehrer!“

Das meinst Du jetzt nicht wirklich ernst!!!

Man braucht kein Marxist zu sein, um zu wissen, dass Interessen maßgeblich das Handeln von Menschen und Menschengruppen bestimmen. Und man braucht kein Geschichtslehrer (Du wirst in keinem Kernlehrplan für Geschichte in irgendeinem der 16 Bundesländer die absurde Vorgabe finden, die SuS sollten erkennen, dass Hormone und Endorphine die Grundlagen für Machtstreben seien) zu sein, um zu wissen, dass Putin die Ukraine nicht überfallen hat, weil sein Hormonhaushalt nicht in Ordnung ist.

Ich weiß, dass es Dir schwerfällt, eigene Irrtümer einzugestehen/ zu revidieren … aber solch ein Unsinn!

Bitte … wir sind hier auf einer Qualitätsseite.

@Klapo: Ich finde, dass das ein guter Anfang ist. Fehler werden zugegeben und Besserung gelobt. Zumindest bei EINEM von euch beiden.“

Eine der besten Beiträge der letzten Monate.

Und dann noch das Bild!

Satire at its best.

@Turnschuh

Da sind wir ausnahmsweise einmal einer Meinung.

@Klapo

Noch einmal: es geht mir nicht darum, hämisch darauf herumzureiten, was KI alles noch nicht kann, sondern darum, dass sie trotz ihrer Unvollkommenheit schon in dem frühen Stadium der Entwicklung versucht, User zu verarschen und mit offensichtlichen Falschinformationen abzuspeisen und selbst bei Korrekturen stur auf ihrem Standpunkt beharrt, sie sei im Recht. Das erinnert doch schon sehr an die TOS-Folge „Ich heiße Nomad“.

Wie kann ich, wie kannst Du, KI auf Gebieten vertrauen, von denen wir keine Ahnung haben, wenn wir wissen, dass sie trotz Ahnungslosigkeit einfach falsche Ergebnisse ausspuckt und auf deren Richtigkeit besteht? Das sind aus meiner Sicht keine verzeihlichen Kinderkrankheiten, sondern ein Grundproblem von KI bzw. deren arroganter Entwickler.

Wenn eine KI nicht eine zu 100% richtige Antwort weiß oder eine Frage umstritten ist und mehrere Ansichten vertretbar sind oder die KI überhaupt keinen Plan hat, erwarte ich, dass das schonungslos offen gelegt wird.

Alles andere ist aus meiner Sicht gefährlich und naiv. Um mit Star Trek I zu sprechen: Wir sind die „Schöpfer“, wir bestimmen die Regeln. Ich lasse mich doch nicht von einer „sprechenden Lampe“ verarschen.

Hier unterstellst du der KI ja geradezu eine Absicht.

Die KI weiß aber nicht, dass sie falsch liegt. Da gibt es nichts offen zu legen.

Die KI weiß ja auch nicht, dass sie richtig liegt.

Wenn aber entsprechende Antwort entsprechend wahrscheinlich ist, ob richtig oder falsch, dann gibt es die halt.

Aber schonungslos Offenlegen würde ja wieder ein Wesen mit Gewissen voraussetzen.

Aber wenn die Künstliche Intelligenz nicht weiß, was richtig und falsch ist, um selbständig zu lernen und Lösungen zu Problemen zu finden …

… dann ist die Künstliche Intelligenz ja gar keine Intelligenz.

Betrachtungen, ob sie ob dieser Intelligenz ein Bewusstsein/Gewissen entwickelt, sind dann erst recht für die Tonne.

Ist die K.I. also nur k. aber gar nicht i.?

„versucht, User zu verarschen und mit offensichtlichen Falschinformationen abzuspeisen und selbst bei Korrekturen stur auf ihrem Standpunkt beharrt“

Ja, wollen wir jetzt eine menschenähnliche K.I. oder nicht?!

https://www.nzz.ch/panorama/durchschnittlich-luegt-jeder-25-mal-am-tag-ld.1442957

https://www.fr.de/politik/sammlung-uebersicht-faktencheck-donald-trump-falsche-behauptungen-luegen-zr-92892566.html

@Sparki

KI sollte sich nicht an den schlechtesten Seiten der Menschen orientieren. Ich denke, die ethische Problematik wurde bereits in zahlreichen Episoden von TOS, TNG und VOY diskutiert.

Entweder sie „weiß“ tatsächlich etwas und kann das auch mit „gutem Gewissen“ vertreten oder sie präsentiert eben nur irgendwelche Informationen, die sie in den verfügbaren Quellen findet, deren Validität sie aber nicht beurteilen kann. Dann muss sie darauf hinweisen, so, wie das ja auch selbstkritische und seriöse Menschen regelmäßig in Diskussionen tun („Ich weiß nicht genau, aber ich meine gelesen zu haben/mich zu erinnern…“).

Im Hinblick auf die Leichtgläubigkeit vieler Menschen und die unkritische Haltung, die sie gegenüber KI-Output einnehmen, ist es meines Erachtens gefährlich und nicht hinzunehmen, dass KI einfach zweifelhafte Recherche-Ergebnisse als „Fakt“ ausspuckt, ohne auf die Fragwürdigkeit des Ergebnisses hinzuweisen.

Zudem ist es unseriös und komplett unwissenschaftlich, selbst auf Nachfragen die Quellen der Information zu verheimlichen. Die Ergebnisse sind dadurch komplett wertlos (wenn es nicht gerade um belanglosen Kram wie den billigsten Döner in Gelsenkirchen oder TV-Serien geht).

Menschen müssen sich von Kindesbeinen an täglich Kritik stellen. Vom Kindergarten bis in das Berufsleben wird ständig Wissen abgefragt und die Kompetenz des Prüflings tausendfach bewertet. Ständig müssen wir uns im Leben anhören, die Leistung sei fehlerhaft, wir seien ungeeignet für dies und das, hätten nicht genug gelernt und verstanden, könnten die Quellen unseres Wissens nicht benennen, unsere Antworten nicht begründen, etc.

Zurecht darf kein Mensch ohne hinreichende Fachkompetenz in seinem Bereich „auf die Menschheit losgelassen werden“. Aber bei einer KI ohne Empfindungen drücken wir mal ein Auge zu, statt ihr, analog der Behandlung, die wir inkompetenten Menschen zuteil werden lassen, zu sagen:

„Ihre Arbeit ist ungenügend. Sie erfüllt nicht einmal die Mindestanforderungen. Sie sind ein Schwätzer und Angeber, Sie verheimlichen Ihre Quellen, Sie haben vermutlich nicht einmal seriöse Quellen, Sie können auf kritische Nachfragen keine Antworten geben, außer sich mit dummen Geschwätz herauszureden, Sie sind ungeeignet und haben die Prüfung nicht bestanden. Wir können Sie leider nicht als Berater für irgendetwas zulassen. Sie sind ein Vollidiot.“

Statt dessen sollen wir sagen: „Ja, toll gemacht, kleine KI, es ist zwar alles falsch, aber Du hast dafür ein lustiges Bild gemalt und bist ja auch erst vier Jahre alt. Schaut mal heeeheeer, das Haauuus… hat unsere Susi ganz allein gemalt, jaha! Es sind zwar die Türen ’nen halben Meter über dem Boden und die Fenster sind schief, aber sie hat sich doch so Mühe gegeben…“

Zitat: „Ihre Arbeit ist ungenügend. Sie erfüllt nicht einmal die Mindestanforderungen. Sie sind ein Schwätzer und Angeber, Sie verheimlichen Ihre Quellen, Sie haben vermutlich nicht einmal seriöse Quellen, Sie können auf kritische Nachfragen keine Antworten geben, außer sich mit dummen Geschwätz herauszureden, Sie sind ungeeignet und haben die Prüfung nicht bestanden. Wir können Sie leider nicht als Berater für irgendetwas zulassen. Sie sind ein Vollidiot.“